Imagen : Las IA generativas (GPT-3, Copilot, Gemini, Gopher, Chinchilla, PaLM, Human, etc.) se entrenan con conjuntos de datos muy grandes, que pueden contener miles de millones de textos, imágenes, música o vídeos.

Estas redes neuronales profundas están compuestas de muchos parámetros. Por ejemplo, el modelo GPT-3 de OpenAI contiene 175 mil millones de parámetros.

¿Cómo puede el aumento ciego de estos parámetros dar lugar a una forma de inteligencia?

Todavía hay algo profundamente perturbador en esta manifestación cognitiva porque nos dice que la inteligencia puede surgir automáticamente.

* En la escala corta utilizada en los países de habla inglesa, mil millones equivalen a 109 o mil millones o mil millones.

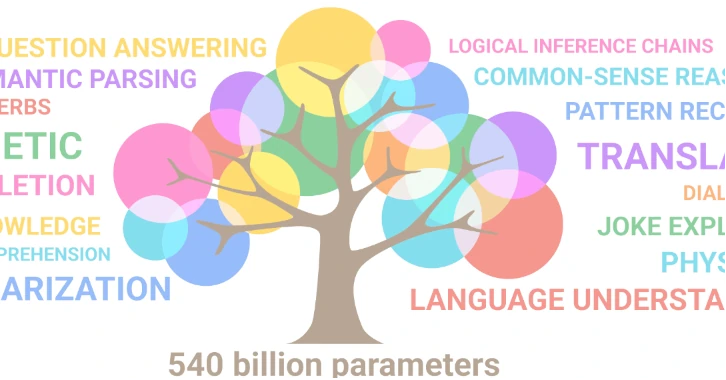

Imagen publicada por Sharan Narang y Aakanksha Chowdhery, ingenieros de software de Google Research.

Los parámetros de la red neuronal son las variables internas de un modelo de IA. Estos parámetros se ajustan automáticamente durante el aprendizaje a partir de los datos de entrada.

Por ejemplo, el modelo GPT-3 de OpenAI tiene 175 mil millones de parámetros. El modelo DALL-E de OpenAI tiene 12 mil millones de parámetros. Se dice que el modelo Gemini Ultra de Google tiene 540 mil millones de parámetros.

El número de parámetros depende de la estructura de la red, es decir del número de capas, del número de neuronas por capa y del tipo de conexión entre las capas.

El número de parámetros viene dado por la siguiente fórmula: P = (d+1)h + (h+1)o donde d es el número de neuronas de entrada, h es el número de neuronas ocultas y o es el número de neuronas de salida. El término +1 corresponde al sesgo, que es un parámetro adicional que se agrega a cada capa para evitar la tendencia humana natural a favorecer ciertos resultados.

El número de parámetros influye en la capacidad de aprendizaje de una red neuronal y por tanto en el rendimiento y comportamiento del modelo. Cuantos más parámetros haya, más capacidad tendrá el sistema para producir resultados correctos y consistentes. Sin embargo, ¡hay un límite!

Un fenómeno llamado "sobreajuste" penaliza al sistema cuando la cantidad de parámetros es demasiado grande en comparación con la cantidad de datos disponibles.

Si queremos aumentar la cantidad de parámetros en una red neuronal, también debemos aumentar los datos de entrenamiento.

Esto explica por qué el apetito de los operadores por nuestros datos es insaciable.

En las redes neuronales artificiales (RNA), cada neurona realiza un cálculo que es una suma ponderada de sus entradas, luego aplica una función de activación con umbral para determinar su salida, que proporciona a la siguiente capa.

De este simple proceso matemático surge una singularidad.

La red solo predice la siguiente palabra o token que seguirá en la oración. Y, sin embargo, surge una oración ordenada, racional y coherente aunque sea resultado de un proceso probabilístico.

Para este mago del lenguaje que hace malabarismos con las palabras sin preocuparse por su significado, la noción de verdad es irrelevante. El sistema no busca dar respuestas correctas, sino frases probables.

En otras palabras, un sistema que no tiene conexión con nuestra realidad, desprovisto de significado y conocimiento y que no distingue lo "verdadero" de lo "falso", puede proporcionar una respuesta "inteligente".

Es gracias a su inmenso corpus de aprendizaje que la IA da la impresión de comprender el contexto de la frase, la intención del autor y los matices del lenguaje.

¡¡Hay algo profundamente perturbador en esta manifestación!!

¿Cómo puede aparecer un fenómeno tan complejo y sofisticado como la inteligencia en un entorno virtual?

Ejemplos de conceptos emergentes:

- Justo después del Big Bang, el universo es extremadamente caliente y denso. En este ambiente extremo, de la energía pura surge la materia, según la ecuación de Einstein, E=mc². Así, del universo primitivo emergen partículas elementales como quarks, electrones y neutrinos, que antes no existían.

- La vida es un fenómeno emergente, resulta de la interacción de componentes más simples, como las moléculas químicas que la constituyen. Sin embargo, presenta propiedades nuevas e irreducibles a estos componentes. A partir de una determinada organización molecular aparece en un entorno donde antes no existía.

Un concepto emergente surge de un concepto más fundamental sin dejar de ser nuevo e irreductible a él. En otras palabras, aparecen nuevas propiedades con el concepto surgiendo de un entorno donde antes no estaba presente. Estas nuevas propiedades parecen ser una respuesta natural a las condiciones físicas específicas de un entorno.

Los modelos de IA anteriores a 2017 se entrenaron con conjuntos de datos mucho más pequeños que los que se utilizan hoy. Estaban lejos de ser perfectas y las IA generativas no funcionaban muy bien.

A medida que aumentan los datos disponibles para el aprendizaje, los científicos de datos han aumentado intuitivamente la cantidad de parámetros. A partir de un umbral milagroso, notaron la aparición de una mejora significativa en los resultados.

Este fenómeno se produjo en 2017 con el modelo GPT-2 (Generative Pre-trained Transformer 2) que marcó un punto de inflexión en el campo de la generación de textos, al demostrar su capacidad para producir textos con calidad humana.

Qué pasó ?

Antes de 2017, la escala de los modelos (datos de aprendizaje y arquitecturas neuronales) aumentó pero no pasó nada, el rendimiento fue pobre y se estancaron. Luego, de repente, cuando la escala alcanzó un umbral, hubo una transición de fase. Es decir, un cambio en el estado físico del sistema, provocado por la diversidad de datos y parámetros.

De repente, aparecieron interacciones más ricas, profundas y complejas entre neuronas.

Lo destacable de esta milagrosa evolución es el surgimiento de capacidades cognitivas más sofisticadas que ahora nos parecen "inteligentes".

A los científicos les resulta difícil explicar esta transición de fase. Sin embargo, ¡una “inteligencia” emerge matemáticamente de la interacción de componentes muy simples, como datos, algoritmos, modelos y parámetros!

¿Qué nos dice este surgimiento de una máquina sobre la naturaleza de la inteligencia misma?

El aprendizaje automático es un proceso no lineal, lo que significa que pequeños cambios pueden provocar grandes cambios en el comportamiento del modelo. Por el momento, no entendemos cómo los modelos toman sus decisiones y esto dificulta predecir sus comportamientos futuros.

El campo de la IA está evolucionando muy rápidamente y constantemente surgen nuevas tecnologías y arquitecturas. De la creciente complejidad de los modelos podrían surgir otras propiedades inesperadas, como la creatividad, el arte, la comprensión de la realidad e incluso la conciencia.

La IA fue diseñada originalmente para imitar las capacidades del cerebro humano. Para ello, se inspiró en modelos de neuronas biológicas para crear redes neuronales artificiales.

Es probable que en el futuro la IA y la investigación del cerebro se enriquezcan mutuamente.

Al utilizar la IA y dejarla evolucionar por sí sola, es posible que nos proporcione las claves para desbloquear los misterios del cerebro humano.

"El azar es el dios de los inventores". - Pierre Dac (1893-1975) humorista francés.