El concepto de "Self-Consuming Generative Models Go Mad" (modelos generativos autoconsumidores que se vuelven locos) se refiere, en el campo de la inteligencia artificial, a la producción de datos de aprendizaje por parte de la IA misma.

Los modelos generativos son algoritmos que aprenden a generar nuevos datos "imitando" un conjunto de datos de entrenamiento producido por humanos. La producción de datos de aprendizaje es costosa y lleva mucho tiempo. Los datos deben recolectarse, limpiarse, anotarse y formatearse para que puedan ser utilizados correctamente por la IA.

Los científicos no pudieron resistir la tentación de utilizar los datos sintéticos generados por los propios modelos generativos para entrenar nuevos modelos más rápidamente.

La idea central es crear un modelo generativo capaz de producir sus propios datos de aprendizaje. Este proceso se itera, y el modelo se vuelve cada vez más capaz de generar datos complejos e inéditos.

Las ventajas imaginadas son numerosas. En primer lugar, el modelo no está limitado por la cantidad inicial de datos. Puede explorar dominios desconocidos y descubrir nuevos conceptos. Gracias a su aprendizaje autosupervisado, podría mejorar su rendimiento de manera iterativa. Por ejemplo, podría generar estructuras moleculares inéditas como candidatas para nuevos medicamentos.

Sin embargo, existe un enorme desafío asociado con este enfoque.

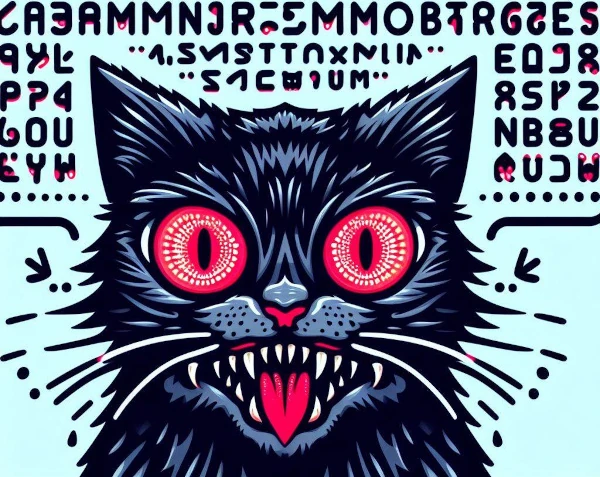

El Self-Consuming Generative Models Go Mad es un fenómeno en el que los modelos de IA generativos se entrenan en datos sintéticos producidos por otros modelos, creando bucles autofágicos. Cuando una IA intenta aprender el contenido generado por otra IA, se vuelve loca.

La repetición de este proceso crea un bucle autofágico en el que los datos de aprendizaje se vuelven caóticos. Sin datos reales frescos, los futuros modelos generativos están destinados al fracaso.

Este proceso de autofagia conduce a una disminución progresiva de la calidad y a una dilución de la diversidad en el contenido generado. El modelo produce entonces salidas incoherentes y redundantes.

Si el modelo no está expuesto a una variedad suficiente de ejemplos, no logra aprender patrones significativos y genera producciones repetitivas.

Al centrarse únicamente en su propia producción, se aleja de la realidad y genera resultados aberrantes.

Finalmente, sufre de sobreajuste: memoriza detalles insignificantes y pierde su capacidad de generalizar. Luego reproduce sus propios sesgos infinitamente.

En algunos escenarios, los modelos generativos pueden volverse "locos" o malfuncionar de manera inesperada, incluso autodestructiva. Por ejemplo, un modelo podría priorizar la novedad hasta el punto de explorar territorios cada vez más inestables.

La falta de regulación expone al modelo a un descontrol en el que los contenidos se vuelven extremos, ofensivos o impactantes. Entonces, corremos el riesgo de no entender los resultados generados por el modelo.

Esta noción especulativa destaca las preocupaciones asociadas con el uso de modelos de IA autónomos o mal controlados. Es una reflexión importante sobre cómo diseñar y regular estas tecnologías de manera responsable.

En resumen, cuando los modelos de IA se entrenan en sus propios datos, se aíslan del mundo real y de sus valores. Al igual que la endogamia en la naturaleza, donde la reproducción entre individuos genéticamente cercanos conduce a un empobrecimiento del acervo genético y a la acumulación de defectos, este cierre cognitivo provoca un empobrecimiento intelectual y una deriva progresiva: ¡las IAs se vuelven locas!