Le concept de "Self-Consuming Generative Models Go Mad" (Modèles génératifs auto-consommateurs qui deviennent fous) fait référence, dans le domaine de l'intelligence artificielle, à la production de données d'apprentissage par l'IA elle-même.

Les modèles génératifs sont des algorithmes qui apprennent à générer de nouvelles données, en "imitant" un ensemble de données d'entraînement produites par les humains. La production de données d'apprentissage est coûteuse et chronophage. Il faut collecter, nettoyer, annoter et formater les données pour qu'elles puissent être utilisées correctement par l'IA.

Les scientifiques n'ont pas résisté à la tentation d’utiliser les données synthétiques générées par les modèles génératifs eux-mêmes afin de former de nouveaux modèles plus rapidement.

L'idée centrale est de créer un modèle génératif capable de produire ses propres données d'apprentissage. Ce processus est ensuite itéré, le modèle s'affinant et devenant de plus en plus capable de générer des données complexes et inédites.

Les avantages imaginés sont nombreux. Tout d'abord le modèle n'est pas limité par la quantité de données initiales. Il peut explorer des domaines inconnus et découvrir de nouveaux concepts. Grâce à son apprentissage auto-supervisé, il pourrait améliorer ses performances de manière itérative. Par exemple, il pourrait générer des structures moléculaires inédites candidates pour de nouveaux médicaments.

Cependant, il existe un énorme défi associé à cette approche.

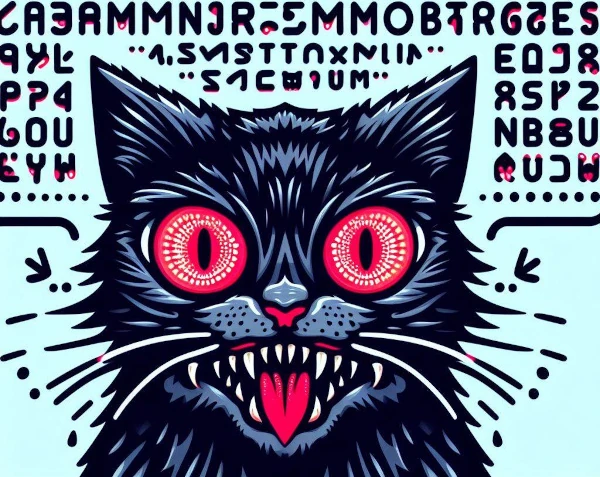

Le Self-Consuming Generative Models Go Mad est un phénomène où des modèles d’IA génératifs s’entraînent sur des données synthétiques produites par d’autres modèles, créant des boucles autophages (qui se consomment elles-mêmes). Lorsqu'une IA essaie d'apprendre le contenu généré par une autre IA, elle devient dingue.

La répétition de ce processus crée une boucle autophage dont les données d'apprentissage deviennent chaotiques. Faute de données réelles fraîches, les futurs modèles génératifs sont voués à l'échec.

Ce processus d'autophagie conduit à une diminution progressive de la qualité et à une dilution de la diversité des contenus générés. Le modèle produit alors des sorties incohérentes et redondantes.

Si le modèle n'est pas exposé à une variété suffisante d'exemples, il ne parvient plus à apprendre des patterns significatifs et génère des productions répétitives.

En se concentrant uniquement sur sa propre production, il s’éloigne de la réalité et génère des résultats aberrants.

Enfin, il souffre d’overfitting : il mémorise des détails insignifiants et perd sa capacité à généraliser. Il reproduit alors ses propres biais à l’infini.

Dans certains scénarios, les modèles génératifs peuvent devenir "fous" ou dysfonctionner d'une manière imprévue, voire auto-destructrice. Par exemple, un modèle pourrait privilégier la nouveauté au point d’explorer des territoires de plus en plus instables.

L'absence de régulation expose le modèle à un emballement dont les contenus deviennent extrêmes, offensants ou choquants. On risque alors de ne plus comprendre les résultats générés par le modèle.

Cette notion spéculative souligne les préoccupations associées à l'utilisation de modèles d’IA autonomes ou mal contrôlés. C'est une réflexion importante sur la manière de concevoir et de réguler ces technologies de façon responsable.

En résumé, lorsque les modèles d'IA s'entraînent sur leurs propres données, ils s'isolent du monde réel et de ses valeurs. À l'image de la consanguinité dans la nature, où la reproduction entre individus génétiquement proches entraîne un appauvrissement du patrimoine génétique et l'accumulation de défauts, cette fermeture cognitive provoque un appauvrissement intellectuel et une dérive progressive : les IA deviennent folles !