O conceito de "Self-Consuming Generative Models Go Mad" (modelos generativos autoconsumidores que enlouquecem) refere-se, no campo da inteligência artificial, à produção de dados de aprendizado pela própria IA.

Os modelos generativos são algoritmos que aprendem a gerar novos dados "imitando" um conjunto de dados de treinamento produzido por humanos. A produção de dados de aprendizado é custosa e demorada. Os dados devem ser coletados, limpos, anotados e formatados para que possam ser usados corretamente pela IA.

Os cientistas não resistiram à tentação de usar os dados sintéticos gerados pelos próprios modelos generativos para treinar novos modelos mais rapidamente.

A ideia central é criar um modelo generativo capaz de produzir seus próprios dados de aprendizado. Esse processo é então iterado, e o modelo se torna cada vez mais capaz de gerar dados complexos e inéditos.

As vantagens imaginadas são numerosas. Primeiro, o modelo não é limitado pela quantidade inicial de dados. Ele pode explorar domínios desconhecidos e descobrir novos conceitos. Graças ao seu aprendizado autossupervisionado, poderia melhorar seu desempenho de maneira iterativa. Por exemplo, poderia gerar estruturas moleculares inéditas como candidatas para novos medicamentos.

No entanto, existe um enorme desafio associado a essa abordagem.

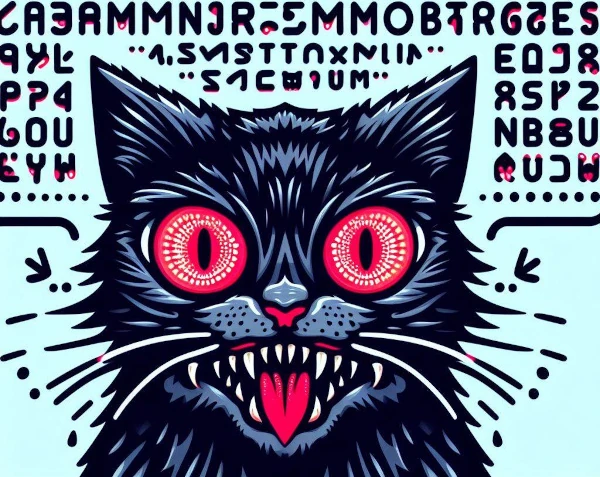

O Self-Consuming Generative Models Go Mad é um fenômeno em que modelos de IA generativos treinam em dados sintéticos produzidos por outros modelos, criando loops autofágicos. Quando uma IA tenta aprender o conteúdo gerado por outra IA, ela enlouquece.

A repetição desse processo cria um loop autofágico em que os dados de aprendizado se tornam caóticos. Sem dados reais frescos, os futuros modelos generativos estão fadados ao fracasso.

Esse processo de autofagia leva a uma diminuição progressiva da qualidade e a uma diluição da diversidade no conteúdo gerado. O modelo então produz saídas incoerentes e redundantes.

Se o modelo não for exposto a uma variedade suficiente de exemplos, ele não consegue aprender padrões significativos e gera produções repetitivas.

Ao se concentrar apenas em sua própria produção, ele se afasta da realidade e gera resultados aberrantes.

Por fim, sofre de overfitting: memoriza detalhes insignificantes e perde sua capacidade de generalizar. Ele então reproduz seus próprios viéses infinitamente.

Em alguns cenários, os modelos generativos podem "enlouquecer" ou malfuncionar de maneira inesperada, até mesmo autodestrutiva. Por exemplo, um modelo pode priorizar a novidade a ponto de explorar territórios cada vez mais instáveis.

A falta de regulamentação expõe o modelo a um descontrole em que os conteúdos se tornam extremos, ofensivos ou chocantes. Corremos então o risco de não entender mais os resultados gerados pelo modelo.

Essa noção especulativa destaca as preocupações associadas ao uso de modelos de IA autônomos ou mal controlados. É uma reflexão importante sobre como conceber e regular essas tecnologias de forma responsável.

Em resumo, quando os modelos de IA treinam em seus próprios dados, eles se isolam do mundo real e de seus valores. Assim como a consanguinidade na natureza, onde a reprodução entre indivíduos geneticamente próximos leva ao empobrecimento do patrimônio genético e ao acúmulo de defeitos, esse fechamento cognitivo provoca um empobrecimento intelectual e uma deriva progressiva: as IAs enlouquecem!