Os parâmetros da rede neural são as variáveis internas de um modelo de IA. Esses parâmetros são ajustados automaticamente durante o aprendizado dos dados de entrada.

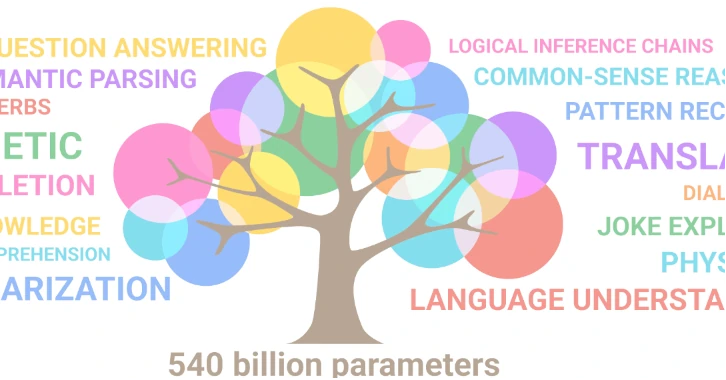

Por exemplo, o modelo GPT-3 da OpenAI possui 175 bilhões de parâmetros. O modelo DALL-E da OpenAI possui 12 bilhões de parâmetros. Diz-se que o modelo Gemini Ultra do Google tem 540 bilhões de parâmetros.

O número de parâmetros depende da estrutura da rede, ou seja, do número de camadas, do número de neurônios por camada e do tipo de conexão entre as camadas.

O número de parâmetros é dado pela seguinte fórmula: P = (d+1)h + (h+1)o onde d é o número de neurônios de entrada, h é o número de neurônios ocultos e o é o número de neurônios de saída. O termo +1 corresponde ao viés, que é um parâmetro adicional adicionado a cada camada para evitar a tendência humana natural de favorecer determinados resultados.

O número de parâmetros influencia a capacidade de aprendizagem de uma rede neural e, portanto, o desempenho e comportamento do modelo. Quanto mais parâmetros houver, mais o sistema terá capacidade de produzir resultados corretos e consistentes. Porém existe um limite!

Um fenômeno chamado “overfitting” penaliza o sistema quando o número de parâmetros é muito grande comparado ao número de dados disponíveis.

Se quisermos aumentar o número de parâmetros em uma rede neural, devemos também aumentar os dados de treinamento.

Isto explica por que o apetite dos operadores pelos nossos dados é insaciável.

Nas redes neurais artificiais (RNA), cada neurônio realiza um cálculo que é uma soma ponderada de suas entradas e, em seguida, aplica uma função de ativação com limite para determinar sua saída, que fornece à próxima camada.

A partir deste processo matemático simples, surge uma singularidade.

A rede apenas prevê a próxima palavra ou token que se seguirá na frase. E, no entanto, surge uma frase ordenada, racional e coerente, embora seja o resultado de um processo probabilístico.

Para este mágico da linguagem que faz malabarismos com as palavras sem se preocupar com o seu significado, a noção de verdade é irrelevante. O sistema não busca fornecer respostas corretas, mas sim sentenças prováveis.

Por outras palavras, um sistema que não tem qualquer ligação com a nossa realidade, desprovido de significado e conhecimento e que não distingue o “verdadeiro” do “falso”, pode fornecer uma resposta “inteligente”.

É graças ao seu imenso corpus de aprendizagem que a IA dá a impressão de compreender o contexto da frase, a intenção do autor e as nuances da linguagem.

Há algo profundamente perturbador nesta manifestação!!

Como pode um fenômeno tão complexo e sofisticado como a inteligência aparecer em um ambiente virtual?

Exemplos de conceitos emergentes:

- Logo após o Big Bang, o universo está extremamente quente e denso. Neste ambiente extremo, da energia pura emerge a matéria, de acordo com a equação de Einstein, E=mc². Assim, partículas elementares como quarks, elétrons, neutrinos, que não existiam antes, emergem do universo primitivo.

- A vida é um fenómeno emergente, resulta da interação de componentes mais simples, como as moléculas químicas que a constituem. Porém, apresenta propriedades novas e irredutíveis a esses componentes. A partir de uma determinada organização molecular surge em um ambiente onde antes não existia.

Um conceito emergente surge de um conceito mais fundamental, embora permaneça novo e irredutível a ele. Ou seja, novos imóveis surgem com o conceito emergindo de um ambiente onde antes não estava presente. Estas novas propriedades parecem ser uma resposta natural às condições físicas específicas de um ambiente.

Os modelos de IA anteriores a 2017 foram treinados em conjuntos de dados muito menores do que os usados hoje. Eles estavam longe de ser perfeitos, as IAs generativas não funcionavam muito bem.

À medida que os dados disponíveis para aprendizagem aumentam, os cientistas de dados aumentam intuitivamente o número de parâmetros. A partir de um limiar milagroso, notaram o aparecimento de uma melhoria significativa nos resultados.

Este fenómeno ocorreu em 2017 com o modelo GPT-2 (Generative Pre-trained Transformer 2) que marcou uma viragem no campo da geração de texto, ao demonstrar a sua capacidade de produzir textos de qualidade humana.

O que aconteceu ?

Antes de 2017, a escala dos modelos (dados de aprendizagem e arquiteturas neurais) aumentou, mas nada aconteceu, o desempenho foi fraco e estagnaram. Então, de repente, quando a escala atingiu um limite, houve uma transição de fase. Em outras palavras, uma mudança no estado físico do sistema, causada pela diversidade de dados e parâmetros.

De repente, surgiram interações mais ricas, profundas e complexas entre os neurônios.

O que é notável nesta evolução milagrosa é o surgimento de capacidades cognitivas mais sofisticadas que agora nos parecem “inteligentes”.

Os cientistas têm dificuldade em explicar esta transição de fase. Contudo, uma “inteligência” emerge matematicamente da interação de componentes muito simples, como dados, algoritmos, modelos e parâmetros!!

O que esse surgimento de uma máquina nos diz sobre a natureza da própria inteligência?

O aprendizado de máquina é um processo não linear, o que significa que pequenas mudanças podem levar a grandes mudanças no comportamento do modelo. Neste momento, não compreendemos como os modelos tomam as suas decisões e isso torna difícil prever os seus comportamentos futuros.

O campo da IA está a evoluir muito rapidamente, com novas tecnologias e arquiteturas a surgir constantemente. Da crescente complexidade dos modelos poderão surgir outras propriedades inesperadas, como a criatividade, a arte, a compreensão da realidade e até a consciência.

A IA foi originalmente projetada para imitar as capacidades do cérebro humano. Para isso, ela se inspirou em modelos de neurônios biológicos para criar redes neurais artificiais.

É provável que, no futuro, a IA e a investigação do cérebro se enriqueçam mutuamente.

Ao usar a IA e deixá-la evoluir por conta própria, é possível que ela nos forneça as chaves para desvendar os mistérios do cérebro humano.

“O acaso é o deus dos inventores.” - Pierre Dac (1893-1975) humorista francês.