Les paramètres des réseaux de neurones sont les variables internes d’un modèle d’IA. Ces paramètres sont ajustés automatiquement pendant l’apprentissage à partir des données d'entrées.

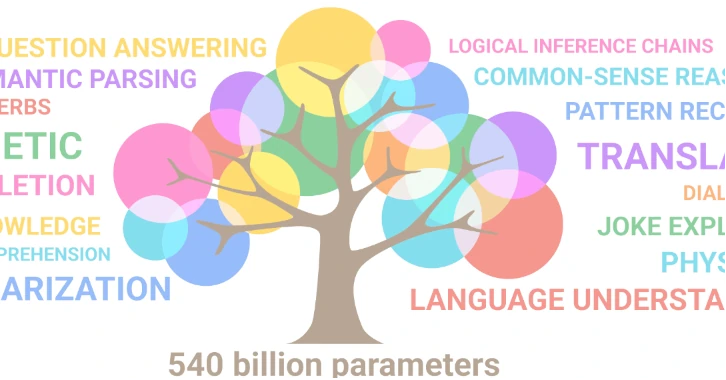

Par exemple, le modèle GPT-3 d’OpenAI a 175 milliards de paramètres. Le modèle DALL-E d’OpenAI a 12 milliards de paramètres. Le modèle Gemini Ultra de Google aurait 540 milliards de paramètres.

Le nombre de paramètres dépend de la structure du réseau, c’est-à-dire du nombre de couches, du nombre de neurones par couche, et du type de connexion entre les couches.

Le nombre de paramètres est donné par la formule suivante : P = (d+1)h + (h+1)o où d est le nombre de neurones d’entrée, h est le nombre de neurones cachés, et o est le nombre de neurones de sortie. Le terme +1 correspond au biais, qui est un paramètre supplémentaire ajouté à chaque couche pour éviter la tendance naturelle humaine à favoriser certains résultats.

Le nombre de paramètres influence la capacité d’apprentissage d’un réseau de neurones et donc la performance et le comportement du modèle. Plus il y a de paramètres et plus le système a la capacité produire des résultats corrects et cohérents. Cependant il y a une limite !

Un phénomène que l'on nomme le "surapprentissage" pénalise le système lorsque le nombre de paramètres est trop grand par rapport au nombre de données disponibles.

Si on veut augmenter le nombre de paramètres dans un réseau de neurones, il faut aussi augmenter les données d’apprentissage.

Cela explique pourquoi l'appétit des opérateurs pour nos données est insatiable.

Dans les réseaux de neurones artificiels (RNA), chaque neurone effectue un calcul qui est une somme pondérée de ses entrées, puis applique une fonction d'activation à seuil pour déterminer sa sortie qu'elle fournit à la couche suivante.

A partir de ce simple processus mathématique, une singularité apparait.

Le réseau ne fait que prédire le prochain mot ou le prochain "token" (morceau de mot) qui va suivre dans la phrase. Et pourtant, une phrase ordonnée, rationnelle et cohérente émerge alors qu'elle est issue d'un processus probabiliste.

Pour ce magicien du langage qui jongle avec les mots sans se soucier de leur sens, la notion de vérité n'est pas pertinente. Le système ne cherche pas à fournir des réponses justes, mais plutôt des phrases probables.

Autrement dit, un système qui n'a aucun de lien avec notre réalité, dénué de sens et de savoir et qui ne distingue pas le "vrai" du "faux", peut fournir une réponse "intelligente".

C'est grâce à son immense corpus d'apprentissage, que l'IA donne l'impression de comprendre le contexte de la phrase, l'intention de l'auteur et les nuances du langage.

Il y a quelque chose de profondément troublant dans cette manifestation !!

Comment un phénomène aussi complexe et sophistiqué que l'intelligence peut appaitre dans un environnement virtuel ?

Exemples de concepts émergeants

- Juste après le Big Bang, l'univers est extrêmement chaud et dense. Dans cet environnement extrême, à partir de l'énergie pure émerge la matière, conformément à l'équation d'Einstein, E=mc². Ainsi, des particules élémentaires telles que les quarks, les électrons, les neutrinos, qui n'existaient pas auparavant, émergent de l'univers primordial.

- La vie est un phénomène émergent, elle résulte de l’interaction de composants plus simples, comme les molécules chimiques qui la constituent. Pourtant elle présente des propriétés nouvelles et irréductibles à ces composants. A partir d'une certaine organisation moléculaire elle apparait dans un environnement où elle n'existait pas auparavant.

Un concept émergent découle d'un concept plus fondamental tout en demeurant nouveau et irréductible à celui-ci. En d'autres termes, des propriétés nouvelles apparaissent avec le concept émergent à partir d'un environnement où il n'était pas présent auparavant. Ces propriétés nouvelles semblent être une réponse naturelle aux conditions physiques spécifiques d'un environnement.

Les modèles d'IA d'avant 2017 étaient entraînés sur des ensembles de données beaucoup plus petits que ceux utilisés aujourd'hui. Ils étaient loin d'être parfaits, les IA génératives ne fonctionnaient pas très bien.

Les données disponibles pour l'apprentissage augmentant, les data scientists ont intuitivement augmentés le nombre de paramètres. A partir d'un seuil miraculeux, ils ont constaté l'apparition d'une amélioration significative des résultats.

Ce phénomène s'est produit en 2017 avec le modèle GPT-2 (Generative Pre-trained Transformer 2) qui a marqué un tournant dans le domaine de la génération de texte, en démontrant sa capacité à produire des textes de qualité humaine.

Que s'est-il passé ?

Avant 2017, l’échelle des modèles (données d'apprentissage et architectures neuronales) augmentait mais rien ne se passait, les performances été médiocres et elles stagnaient. Puis soudainement lorsque l'échelle a atteint un seuil, il y a eu une transition de phase. Autrement dit, un changement d'état physique du système, provoqué par la diversité des données et des paramètres.

Tout à coup, des interactions plus riches, plus profondes et plus complexes entre les neurones sont apparues.

Le fait remarquable dans cette évolution miraculeuse est l'émergence de capacités cognitives plus sophistiquées qui nous paraissent maintenant "intelligentes".

Les scientifiques ont beaucoup de mal à expliquer cette transition de phase. Pourtant une "intelligence" a bien émergé mathématiquement de l’interaction de composants très simples, comme des données, des algorithmes, des modèles et des paramètres !!

Que nous dit cette émergence issue d'une machine, sur la nature de l'intelligence elle-même ?

L'apprentissage automatique est un processus non linéaire, ce qui signifie que de petits changements peuvent entraîner des changements importants dans le comportement du modèle. Pour l'instant, nous ne comprenons pas comment les modèles prennent leurs décisions et cela rend difficile de prédire leurs comportements futurs.

Le domaine de l'IA évolue très rapidement, avec de nouvelles technologies et de nouvelles architectures qui apparaissent constamment. De la complexité croissante des modèles, d'autres propriétés inattendues pourraient émerger, comme la créativité, l'art, la compréhension du réel et même la conscience.

L'IA a été conçue à l'origine pour imiter les capacités du cerveau humain. Pour cela elle s'est inspirée des modèles de neurones biologiques pour créer des réseaux de neurones artificiels.

Il est probable qu'à l'avenir, l'IA et la recherche sur le cerveau s'enrichissent mutuellement.

En utilisant l'IA et en la laissant évoluer toute seule, il est possible qu'elle nous fournisse les clés pour percer les mystères du cerveau humain.

"Le hasard est le dieu des inventeurs." - Pierre Dac (1893-1975) Humoriste français.