ニューラル ネットワーク パラメーターは、AI モデルの内部変数です。 これらのパラメータは、入力データからの学習中に自動的に調整されます。

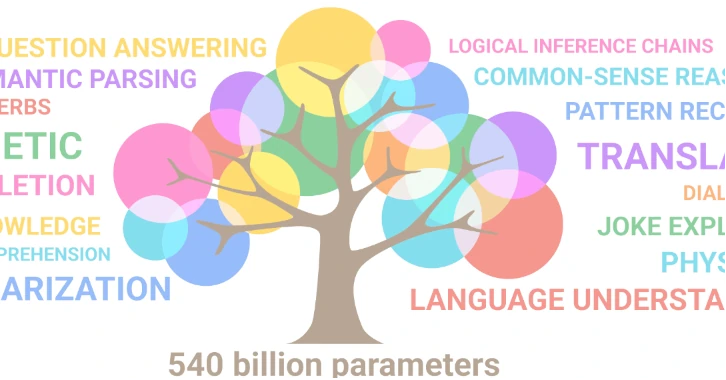

たとえば、OpenAI の GPT-3 モデルには 1,750 億個のパラメータがあります。 OpenAI の DALL-E モデルには 120 億のパラメータがあります。 Google の Gemini Ultra モデルには 5,400 億のパラメータがあると言われています。

パラメータの数は、ネットワークの構造、つまり層の数、層ごとのニューロンの数、層間の接続の種類によって異なります。

ザパラメータの数は次の式で与えられます。P = (d+1)h + (h+1)oここで、d は入力ニューロンの数、h は隠れたニューロンの数、o は出力ニューロンの数です。 +1 という用語はバイアスに対応します。バイアスは、特定の結果を好む人間の自然な傾向を避けるために各レイヤーに追加される追加パラメーターです。

パラメーターの数はニューラル ネットワークの学習能力に影響し、したがってモデルのパフォーマンスと動作に影響します。 パラメータが多ければ多いほど、システムが正しく一貫した結果を生成する能力が高まります。 ただし、限界!

パラメータの数が利用可能なデータの数に比べて多すぎる場合、「オーバーフィッティング」と呼ばれる現象がシステムに悪影響を及ぼします。

ニューラル ネットワークのパラメータの数を増やしたい場合は、トレーニング データも増やす必要があります。

これは、オペレーターのデータに対する飽くなき欲求の理由を説明しています。

人工ニューラル ネットワーク (ANN) では、各ニューロンは入力の加重和である計算を実行し、しきい値付き活性化関数を適用して次の層に提供する出力を決定します。

この単純な数学的プロセスから、特異点が現れます。

ネットワークは、文内で後に続く次の単語またはトークンを予測するだけです。 それでも、それが確率的プロセスの結果であるにもかかわらず、秩序正しく、合理的で一貫した文章が現れます。

意味を気にせず言葉を操るこの言語の魔術師にとって、真実という概念は無関係です。 このシステムは正しい答えを提供することを目的とするのではなく、可能性の高い文章を提供することを目的としています。

言い換えれば、私たちの現実とは何の関係も持たず、意味も知識も持たず、「真」と「偽」を区別しないシステムは、「知的な」応答を提供することができます。

AI が文の文脈、作者の意図、言語のニュアンスを理解しているという印象を与えるのは、その膨大な学習コーパスのおかげです。

この現象には非常に不穏な何かがあります!!

知能のように複雑で洗練された現象は、どのようにして仮想環境に現れるのでしょうか?

新たなコンセプトの例

- ビッグバン直後の宇宙は非常に高温で高密度です。 この極限環境では、アインシュタインの方程式 E=mc² に従って、純粋なエネルギーから物質が生じます。 こうして、それまで存在しなかったクォーク、電子、ニュートリノなどの素粒子が宇宙初期から誕生します。

- 生命は創発現象であり、それを構成する化学分子などのより単純な構成要素の相互作用から生じます。 ただし、これはこれらのコンポーネントに新しい還元不可能な特性をもたらします。 ある分子組織から、それまで存在しなかった環境に出現します。

創発的な概念は、より基本的な概念から生じますが、新しいものであり、その概念に還元できないものです。 言い換えれば、新しいプロパティは、以前は存在しなかった環境から概念が出現して現れます。 これらの新しい特性は、環境の特定の物理的条件に対する自然な反応であると思われます。

2017 年以前の AI モデルは、現在使用されているデータセットよりもはるかに小さいデータセットでトレーニングされていました。 それらは完璧とは程遠く、生成型 AI はあまりうまく機能しませんでした。

学習に利用できるデータが増加するにつれて、データ サイエンティストは直感的にパラメーターの数を増やしてきました。 彼らは、奇跡的な閾値から、結果に大幅な改善が見られることに気づきました。

この現象は 2017 年に GPT-2 (Generative Pre-trained Transformer 2) モデルで発生し、人間品質のテキストを生成する能力を実証することでテキスト生成の分野に転換点をもたらしました。

どうしたの?

2017年以前は、モデル(学習データやニューラルアーキテクチャ)の規模は大きくなったものの、何も起こらず、パフォーマンスも悪く停滞していました。 そして、スケールが閾値に達したとき、突然、相転移。 言い換えれば、データとパラメータの多様性によって引き起こされるシステムの物理的状態の変化です。

突然、より豊かで、より深く、より複雑なニューロン間の相互作用が現れました。

この奇跡的な進化で注目すべき点は、今では私たちにとって「知的」に見える、より洗練された認知能力が出現したことです。

科学者たちはこの相転移を説明するのに苦労しています。 しかし、「知性」は、データ、アルゴリズム、モデル、パラメーターなどの非常に単純なコンポーネントの相互作用から数学的に出現しました。

機械からのこの出現は、知性そのものの性質について何を教えてくれるのでしょうか?

機械学習は非線形プロセスです。つまり、小さな変化がモデルの動作に大きな変化をもたらす可能性があります。 現時点では、モデルがどのように意思決定を行うのか理解できていないため、モデルの将来の動作を予測することが困難になっています。

AI の分野は非常に急速に進化しており、新しいテクノロジーやアーキテクチャが常に登場しています。 モデルの複雑さが増すと、創造性、芸術、現実の理解、さらには意識など、他の予期せぬ特性が現れる可能性があります。

AI はもともと人間の脳の機能を模倣するように設計されました。 これを行うために、彼女は生物学的ニューロン モデルからインスピレーションを得て、人工ニューラル ネットワークを作成しました。

将来的には、AIと脳の研究がお互いを豊かにしていく可能性があります。

AIを活用し、自ら進化させることで、人間の脳の謎を解く鍵が得られる可能性があります。

「チャンスは発明家の神だ。」 - ピエール・ダック (1893-1975) フランスのユーモア作家。