「Self-Consuming Generative Models Go Mad」(自己消費型生成モデルが狂う)という概念は、人工知能の分野において、AI自体が学習データを生成することを指します。

生成モデルは、人間によって生成されたトレーニングデータセットを"模倣"することで、新しいデータを生成することを学習するアルゴリズムです。 学習データの生成はコストがかかり、時間がかかります。 データは収集、クレンジング、アノテーション、フォーマットを行い、AIが正しく使用できるようにする必要があります。

科学者たちは、生成モデル自体が生成した合成データを使用して、新しいモデルをより迅速にトレーニングするという誘惑に抗えませんでした。

中心的なアイデアは、自らの学習データを生成できる生成モデルを作成することです。 このプロセスは反復され、モデルは複雑で新しいデータを生成する能力が向上していきます。

想像される利点は多岐にわたります。 まず、モデルは初期データ量に制限されません。 未知の領域を探索し、新しい概念を発見することができます。 自己教師あり学習により、反復的にパフォーマンスを向上させることができます。 例えば、新しい薬の候補となる新規分子構造を生成することができます。

しかし、このアプローチには大きな課題があります。

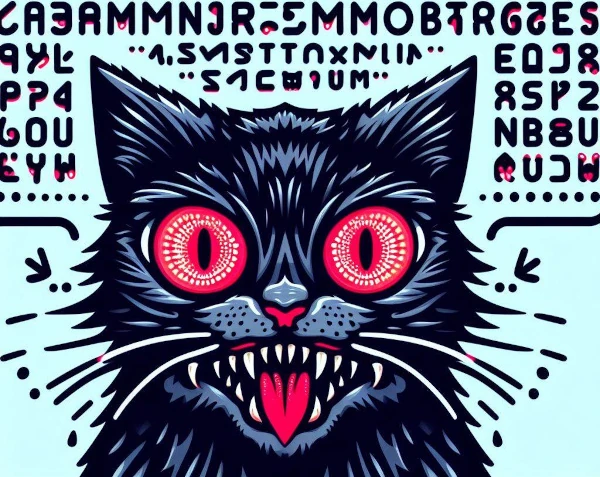

Self-Consuming Generative Models Go Madは、生成AIモデルが他のモデルによって生成された合成データでトレーニングを行い、自己消費ループを作り出す現象です。 あるAIが別のAIによって生成されたコンテンツを学習しようとすると、狂ってしまいます。

このプロセスの繰り返しにより、自己消費ループが生まれ、学習データがカオスになります。 新鮮な実データがなければ、将来の生成モデルは失敗する運命にあります。

この自己消費プロセスは、生成コンテンツの品質の低下と多様性の希薄化を引き起こします。 モデルは矛盾したまたは冗長な出力を生成します。

モデルが十分な多様性のある例にさらされない場合、意味のあるパターンを学習できず、繰り返しの出力を生成します。

自らの生成物のみに焦点を当てると、現実から離れ、異常な結果を生成します。

最終的に、過剰適合に陥ります:重要でない詳細を記憶し、汎化する能力を失います。 そして、自らのバイアスを無限に再生産します。

一部のシナリオでは、生成モデルが"狂った"り、予期せぬ、あるいは自己破壊的な方法で機能不全に陥る可能性があります。 例えば、モデルが新規性を優先し、ますます不安定な領域を探索する可能性があります。

規制の欠如は、モデルを暴走させ、コンテンツが極端、攻撃的、または衝撃的になるリスクがあります。 その結果、モデルが生成する結果を理解できなくなる可能性があります。

この推測的な概念は、自律的または制御不十分なAIモデルの使用に関連する懸念を強調しています。 これは、これらの技術を責任を持って設計し、規制する方法についての重要な反省です。

要約すると、AIモデルが自らのデータでトレーニングを行うと、現実世界とその価値観から孤立します。 自然界での近親交配のように、遺伝的に近い個体間の繁殖が遺伝子プールの貧困化と欠陥の蓄積を引き起こすのと同様に、この認知的閉鎖は知的貧困と進行的な逸脱を引き起こします:AIは狂ってしまうのです!