Das Konzept "Self-Consuming Generative Models Go Mad" (selbstverzehrende generative Modelle, die verrückt werden) bezieht sich im Bereich der künstlichen Intelligenz auf die Erzeugung von Trainingsdaten durch die KI selbst.

Generative Modelle sind Algorithmen, die lernen, neue Daten zu generieren, indem sie einen von Menschen produzierten Trainingsdatensatz "imitieren". Die Erstellung von Trainingsdaten ist kostspielig und zeitaufwendig. Daten müssen gesammelt, bereinigt, annotiert und formatiert werden, damit sie von der KI korrekt verwendet werden können.

Wissenschaftler konnten der Versuchung nicht widerstehen, die von den generativen Modellen selbst erzeugten synthetischen Daten zu verwenden, um neue Modelle schneller zu trainieren.

Die zentrale Idee ist es, ein generatives Modell zu schaffen, das in der Lage ist, seine eigenen Trainingsdaten zu produzieren. Dieser Prozess wird dann iteriert, wobei das Modell immer besser wird, komplexe und neuartige Daten zu generieren.

Die vorgestellten Vorteile sind zahlreich. Zuerst einmal ist das Modell nicht durch die Anfangsmenge der Daten begrenzt. Es kann unbekannte Bereiche erkunden und neue Konzepte entdecken. Dank seines selbstüberwachten Lernens könnte es seine Leistung iterativ verbessern. Zum Beispiel könnte es neuartige molekulare Strukturen generieren, die als Kandidaten für neue Medikamente dienen.

Es gibt jedoch eine große Herausforderung, die mit diesem Ansatz verbunden ist.

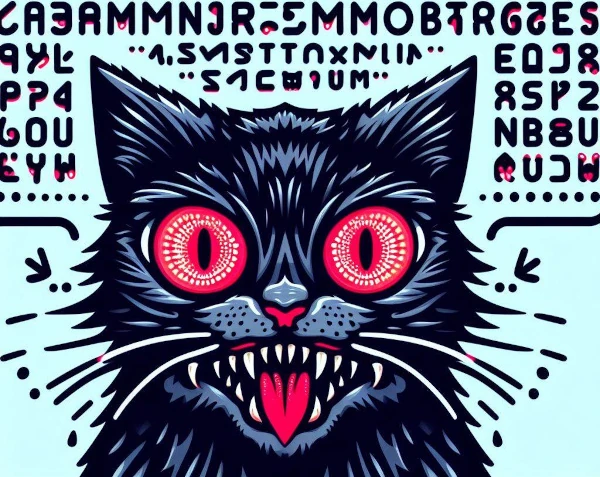

Self-Consuming Generative Models Go Mad ist ein Phänomen, bei dem generative KI-Modelle auf synthetischen Daten trainieren, die von anderen Modellen produziert wurden, und so selbstverzehrende Schleifen erzeugen. Wenn eine KI versucht, den von einer anderen KI generierten Inhalt zu lernen, wird sie verrückt.

Die Wiederholung dieses Prozesses erzeugt eine selbstverzehrende Schleife, in der die Trainingsdaten chaotisch werden. Ohne frische reale Daten sind zukünftige generative Modelle zum Scheitern verurteilt.

Dieser Autophagie-Prozess führt zu einer allmählichen Abnahme der Qualität und einer Verdünnung der Vielfalt der generierten Inhalte. Das Modell produziert dann inkohärente und redundante Ausgaben.

Wenn das Modell nicht einer ausreichenden Vielfalt von Beispielen ausgesetzt ist, gelingt es ihm nicht, signifikante Muster zu lernen, und es generiert repetitive Produkte.

Indem es sich nur auf seine eigene Produktion konzentriert, entfernt es sich von der Realität und generiert abwegige Ergebnisse.

Schließlich leidet es unter Überanpassung: Es merkt sich unwesentliche Details und verliert seine Fähigkeit zur Generalisierung. Es reproduziert dann seine eigenen Voreingenommenheiten endlos.

In einigen Szenarien können generative Modelle "verrückt" werden oder auf unerwartete, sogar selbstzerstörerische Weise fehlfunktionieren. Zum Beispiel könnte ein Modell die Neuheit so sehr priorisieren, dass es zunehmend instabile Gebiete erkundet.

Das Fehlen von Regulierung setzt das Modell der Gefahr aus, außer Kontrolle zu geraten, wobei die Inhalte extrem, beleidigend oder schockierend werden. Dann riskieren wir, die vom Modell generierten Ergebnisse nicht mehr zu verstehen.

Diese spekulative Idee unterstreicht die Bedenken, die mit der Verwendung von autonomen oder schlecht kontrollierten KI-Modellen verbunden sind. Es ist eine wichtige Überlegung, wie man diese Technologien verantwortungsvoll entwirft und reguliert.

Zusammenfassend isolieren sich KI-Modelle, wenn sie auf ihren eigenen Daten trainieren, von der realen Welt und ihren Werten. Ähnlich wie bei Inzucht in der Natur, bei der die Fortpflanzung zwischen genetisch nahen Individuen zu einer Verarmung des Genpools und zur Anhäufung von Defekten führt, verursacht diese kognitive Abschottung eine intellektuelle Verarmung und eine schrittweise Abweichung: KIs werden verrückt!