Neuronale Netzwerkparameter sind die internen Variablen eines KI-Modells. Diese Parameter werden beim Lernen aus Eingabedaten automatisch angepasst.

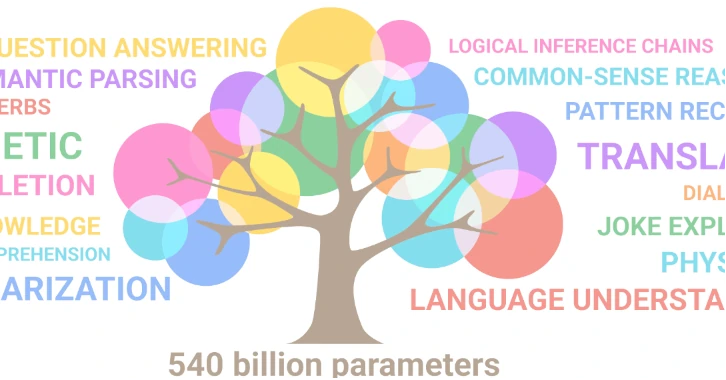

Beispielsweise verfügt das GPT-3-Modell von OpenAI über 175 Milliarden Parameter. Das DALL-E-Modell von OpenAI verfügt über 12 Milliarden Parameter. Googles Gemini Ultra-Modell soll 540 Milliarden Parameter haben.

Die Anzahl der Parameter hängt von der Struktur des Netzwerks ab, also von der Anzahl der Schichten, der Anzahl der Neuronen pro Schicht und der Art der Verbindung zwischen den Schichten.

DERAnzahl der Parameterergibt sich aus der folgenden Formel:P = (d+1)h + (h+1)oDabei ist d die Anzahl der Eingabeneuronen, h die Anzahl der verborgenen Neuronen und o die Anzahl der Ausgabeneuronen. Der Begriff +1 entspricht einer Voreingenommenheit, einem zusätzlichen Parameter, der jeder Ebene hinzugefügt wird, um die natürliche menschliche Tendenz zu vermeiden, bestimmte Ergebnisse zu bevorzugen.

Die Anzahl der Parameter beeinflusst die Lernfähigkeit eines neuronalen Netzwerks und damit die Leistung und das Verhalten des Modells. Je mehr Parameter vorhanden sind, desto besser ist das System in der Lage, korrekte und konsistente Ergebnisse zu liefern. Es gibt jedoch eineLimit !

Ein Phänomen namens „Überanpassung“ benachteiligt das System, wenn die Anzahl der Parameter im Vergleich zur Anzahl der verfügbaren Daten zu groß ist.

Wenn wir die Anzahl der Parameter in einem neuronalen Netzwerk erhöhen wollen, müssen wir auch die Trainingsdaten erhöhen.

Dies erklärt, warum der Appetit der Betreiber auf unsere Daten unstillbar ist.

In künstlichen neuronalen Netzen (KNN) führt jedes Neuron eine Berechnung durch, die eine gewichtete Summe seiner Eingaben darstellt, und wendet dann eine Aktivierungsfunktion mit Schwellenwert an, um seine Ausgabe zu bestimmen, die es an die nächste Schicht weiterleitet.

Aus diesem einfachen mathematischen Prozess entsteht eine Singularität.

Das Netzwerk sagt nur das nächste Wort oder Token voraus, das im Satz folgen wird. Und doch entsteht ein geordneter, rationaler und kohärenter Satz, obwohl er das Ergebnis eines probabilistischen Prozesses ist.

Für diesen Sprachmagier, der mit Wörtern jongliert, ohne sich um deren Bedeutung zu kümmern, ist der Begriff der Wahrheit irrelevant. Das System versucht nicht, richtige Antworten, sondern wahrscheinliche Sätze zu liefern.

Mit anderen Worten: Ein System, das keinen Bezug zu unserer Realität hat, bedeutungs- und wissenslos ist und nicht zwischen „wahr“ und „falsch“ unterscheidet, kann eine „intelligente“ Antwort liefern.

Dank ihres immensen Lernkorpus vermittelt die KI den Eindruck, den Kontext des Satzes, die Absicht des Autors und die Nuancen der Sprache zu verstehen.

Diese Manifestation hat etwas zutiefst Beunruhigendes!!

Wie kann ein so komplexes und anspruchsvolles Phänomen wie Intelligenz in einer virtuellen Umgebung erscheinen?

Beispiele für neue Konzepte

- Kurz nach dem Urknall ist das Universum extrem heiß und dicht. In dieser extremen Umgebung entsteht aus reiner Energie Materie, gemäß Einsteins Gleichung E=mc². So entstehen aus dem frühen Universum Elementarteilchen wie Quarks, Elektronen, Neutrinos, die es vorher nicht gab.

- Leben ist ein entstehendes Phänomen, es resultiert aus der Wechselwirkung einfacherer Komponenten, wie zum Beispiel der chemischen Moleküle, aus denen es besteht. Es verleiht diesen Komponenten jedoch neue und nicht reduzierbare Eigenschaften. Von einer bestimmten molekularen Organisation aus erscheint es in einer Umgebung, in der es vorher nicht existierte.

Ein entstehendes Konzept entsteht aus einem grundlegenderen Konzept, bleibt aber neu und nicht auf dieses reduzierbar. Mit anderen Worten: Neue Eigenschaften entstehen, wenn das Konzept aus einer Umgebung hervorgeht, in der es zuvor nicht vorhanden war. Diese neuen Eigenschaften scheinen eine natürliche Reaktion auf die spezifischen physikalischen Bedingungen einer Umgebung zu sein.

KI-Modelle vor 2017 wurden mit viel kleineren Datensätzen trainiert als heute. Sie waren alles andere als perfekt, generative KIs funktionierten nicht sehr gut.

Da die zum Lernen verfügbaren Daten zunehmen, haben Datenwissenschaftler intuitiv die Anzahl der Parameter erhöht. Ab einer wundersamen Schwelle stellten sie den Anschein einer deutlichen Verbesserung der Ergebnisse fest.

Dieses Phänomen trat 2017 mit dem GPT-2-Modell (Generative Pre-trained Transformer 2) auf, das einen Wendepunkt im Bereich der Textgenerierung markierte, indem es seine Fähigkeit demonstrierte, Texte in menschlicher Qualität zu produzieren.

Was ist passiert?

Vor 2017 nahm der Umfang der Modelle (Lerndaten und neuronale Architekturen) zu, aber es passierte nichts, die Leistung war schlecht und sie stagnierten. Dann plötzlich, als die Skala einen Schwellenwert erreichte, gab es einPhasenübergang. Mit anderen Worten: eine Änderung des physikalischen Zustands des Systems, verursacht durch die Vielfalt der Daten und Parameter.

Plötzlich traten reichhaltigere, tiefere und komplexere Interaktionen zwischen Neuronen auf.

Das Bemerkenswerte an dieser wundersamen Entwicklung ist die Entstehung ausgefeilterer kognitiver Fähigkeiten, die uns nun „intelligent“ erscheinen.

Wissenschaftlern fällt es schwer, diesen Phasenübergang zu erklären. Doch eine „Intelligenz“ ist mathematisch aus dem Zusammenspiel sehr einfacher Komponenten wie Daten, Algorithmen, Modellen und Parametern entstanden!!

Was sagt uns dieses Auftauchen aus einer Maschine über die Natur der Intelligenz selbst?

Maschinelles Lernen ist ein nichtlinearer Prozess, was bedeutet, dass kleine Änderungen zu großen Änderungen im Verhalten des Modells führen können. Im Moment verstehen wir nicht, wie die Modelle ihre Entscheidungen treffen, und das macht es schwierig, ihr zukünftiges Verhalten vorherzusagen.

Der Bereich der KI entwickelt sich sehr schnell weiter und es entstehen ständig neue Technologien und Architekturen. Aus der zunehmenden Komplexität von Modellen könnten sich weitere unerwartete Eigenschaften ergeben, etwa Kreativität, Kunst, Realitätsverständnis und sogar Bewusstsein.

KI wurde ursprünglich entwickelt, um die Fähigkeiten des menschlichen Gehirns nachzuahmen. Dazu ließ sie sich von biologischen Neuronenmodellen inspirieren, künstliche neuronale Netze zu schaffen.

Es ist wahrscheinlich, dass sich KI und Hirnforschung in Zukunft gegenseitig bereichern werden.

Durch den Einsatz von KI und deren eigenständige Weiterentwicklung ist es möglich, dass sie uns den Schlüssel zur Entschlüsselung der Geheimnisse des menschlichen Gehirns liefert.

„Der Zufall ist der Gott der Erfinder.“ - Pierre Dac (1893-1975), französischer Humorist.