Um zu verstehen, wie künstliche neuronale Netze funktionieren, ist es notwendig, die Bedeutung von künstlicher Intelligenz (KI) zu verstehen. KI besteht darin, Computersysteme zu schaffen, die in der Lage sind, Aufgaben ohne menschliches Eingreifen zu automatisieren, aber auch zu lernen, sich anzupassen, zu verbessern, zu kommunizieren und vor allem Entscheidungen zu treffen. In diesem Sinne versucht KI, Aspekte der menschlichen Intelligenz zu reproduzieren.

Die Definition von Intelligenz ist sehr umstritten, aber die Bedeutung, die uns hier interessieren wird, ist die vonFunktionen, die vom Gehirn gesteuert werden. Unabhängig davon, ob es sich um mechanische Funktionen wie das Gehen oder um kognitive Funktionen wie die Entscheidungsfindung handelt, bleibt die Architektur der Funktionen in allen Gehirnbereichen unseres Gehirns gleich. Darüber hinaus sind alle Funktionen von gleicher Bedeutung, ohne Unterschied zwischen den als edel und weniger edel angesehenen. Sie werden alle mit der gleichen Komplexität der Berechnungen durchgeführt, und zwar über ein riesiges Netzwerk aus Milliarden von Neuronen, die zum Informationsaustausch miteinander verbunden sind. Informationen werden durch elektrische und chemische Signale ausgetauscht.

Im menschlichen Gehirn läuft die Kommunikation zwischen Neuronen wie folgt ab:

- Wenn die an der Zellmembran des Neurons ausgelösten elektrischen Signale einen kritischen Schwellenwert erreichen, lösen sie einen kurzen elektrischen Impuls aus, der als „Aktionspotential“ bezeichnet wird. Aktionspotentiale wandern entlang des Axons zur Synapse des Neurons.

- Auf der Ebene der Synapse (Kontaktpunkte zwischen Neuronen) lösen Aktionspotentiale die Freisetzung chemischer Moleküle, sogenannter „Neurotransmitter“, aus.

- Neurotransmitter binden dann an Rezeptoren, die sich auf der Membran des postsynaptischen Neurons (dem Rezeptorneuron) befinden. Diese chemische Bindung löst eine elektrische Reaktion im postsynaptischen Neuron aus.

- Das postsynaptische Neuron integriert alle Eingaben, die es von den sendenden Neuronen erhält, und erzeugt bei Erreichen der kritischen Schwelle wiederum ein Aktionspotential, das sich entlang seines eigenen Axons ausbreitet und so die Informationsübertragung im Netzwerk fortsetzt.

Abhängig von der Art der freigesetzten Neurotransmitter kann die präsynaptische Aktivität eine erregende oder hemmende Wirkung auf die elektrische Aktivität des postsynaptischen Neurons haben. Dadurch wird die Auslösung eines Aktionspotentials mehr oder weniger wahrscheinlich.

Dieser komplexe Prozess ist die Grundlage der Gehirnfunktion und der menschlichen Wahrnehmung. Aus diesem Prozess heraus werden die Forscher ein Modell der künstlichen Intelligenz entwickeln, das zunächst sehr einfach ist und mit fortschreitendem technologischen Fortschritt immer ausgefeilter wird.

DERkünstliches Neuronist die Grundeinheit eines künstlichen neuronalen Netzwerks. Ein künstliches neuronales Netzwerk besteht aus einer Reihe von Schichten miteinander verbundener Neuronen, von denen jede ihre Eingaben von den Ausgaben der vorherigen Schicht bezieht.

Künstliche Neuronen sind keine Computerbits (0 oder 1), sondern mathematische Abstraktionen (Zahlen, Operationen, Funktionen, Gleichungen, Matrizen, Menge, Wahrscheinlichkeit usw.). Mit anderen Worten handelt es sich um Verarbeitungseinheiten, die mathematische Operationen an den ihnen präsentierten Daten durchführen. Sie speichern keine Daten, während Computerbits die Grundlage für die Speicherung digitaler Informationen bilden.

In einem künstlichen neuronalen Netzwerk ist jedes Neuron durch ein Aktivitätsniveau gekennzeichnet, das durch eine Variable namens „Aktivierungspotential". Die Synapse des Neurons wird durch eine weitere Variable namens „synaptisches Gewicht".

- Das Aktivierungspotential repräsentiert den elektrischen Zustand des postsynaptischen Neurons zu einem bestimmten Zeitpunkt. Sie wird durch Summieren der Eingangssignale von präsynaptischen Neuronen berechnet, wobei jedes Signal durch das entsprechende synaptische Gewicht moduliert wird. Das Aktivierungspotential kann je nach Intensität der eingehenden Signale kontinuierlich in einem Bereich von negativen bis positiven Werten variieren.

- Synaptische Gewichte bestimmen, ob eine synaptische Verbindung erregend, hemmend oder null ist. Die Gewichte modulieren den Einfluss von Eingangssignalen auf das Aktivierungspotential. Positive Gewichte erhöhen die Aktivität, negative Gewichte verringern sie und Nullgewichte haben keine Auswirkung.

Das Aktivierungspotential ergibt sich aus der Kombination der mit den synaptischen Gewichten gewichteten Eingangssignale. Dieses Potenzial wird dann einer Aktivierungsfunktion unterzogen, die Nichtlinearität einführt und bestimmt, ob das postsynaptische Neuron eine Reaktion (Aktionspotenzial) erzeugt oder nicht. Letztendlich ermöglichen diese Mechanismen dem Neuron, Informationen zu verarbeiten und adaptiv auf Reize zu reagieren. Die Funktionsweise dieser Variablen ist von grundlegender Bedeutung für die Modellierung des Verhaltens von Neuronen, sowohl in biologischen neuronalen Netzen als auch in künstlichen neuronalen Netzen.

Stellen wir uns ein künstliches neuronales Netzwerk vor, das zur Bildklassifizierung verwendet wird. Dieses Netzwerk umfasst ein postsynaptisches Neuron, das Verbindungen von drei präsynaptischen Neuronen erhält. Jedes dieser drei präsynaptischen Neuronen ist mit einem bestimmten Merkmal des Bildes verbunden, das das Netzwerk analysiert, beispielsweise das Vorhandensein vertikaler Linien, horizontaler Linien und Kurven.

Das postsynaptische Neuron hat ein anfängliches Feuerpotential von 0.

Wenn die drei präsynaptischen Neuronen ihre Signale senden, wird jedes Signal mit dem synaptischen Gewicht multipliziert, das der entsprechenden Verbindung zugeordnet ist. Angenommen, die synaptischen Gewichte sind:

- Synaptisches Gewicht für die vertikale Liniencharakteristik: +0,5

- Synaptisches Gewicht für die Charakteristik horizontaler Linien: -0,3

- Synaptisches Gewicht für die Charakteristik der Kurven: +0,2

Die Signale der drei präsynaptischen Neuronen werden mit den jeweiligen synaptischen Gewichten gewichtet und summiert.

Wenn wir folgende Signale haben:

- Signal für vertikale Linien: 1

- Signal für horizontale Linien: 0,5

- Signal für Kurven: 0,8

Das Aktivierungspotenzial würde wie folgt berechnet:

Aktivierungspotential = (1 * 0,5) + (0,5 * (-0,3)) + (0,8 * 0,2) = 0,5 - 0,15 + 0,16 =0,51

Wenn das Aktivierungspotential einen definierten Schwellenwert (z. B. 0) überschreitet, erzeugt das postsynaptische Neuron ein Aktionspotential, das anzeigt, dass das gewünschte Merkmal im Bild erkannt wurde.

In diesem Beispiel spielen synaptische Gewichte eine entscheidende Rolle bei der Bestimmung der relativen Bedeutung jedes Bildmerkmals. Die mit den synaptischen Gewichten gewichteten Eingangssignale werden zur Berechnung des Aktivierungspotentials verwendet, das bei Überschreiten des Schwellenwerts die Reaktion des postsynaptischen Neurons auslöst. Dadurch kann das neuronale Netzwerk Entscheidungen auf der Grundlage der im Bild erkannten Merkmale treffen.

InfrastrukturHardwareDie Funktionsweise eines künstlichen neuronalen Netzwerks hat nichts Biologisches an sich, sie ist dieselbe wie die der klassischen Datenverarbeitung (Mikroprozessoren, Grafikkarten usw.).

InfrastrukturSoftwareeines künstlichen neuronalen Netzwerks ist anders. Algorithmen für maschinelles Lernen lernen aus Daten und passen ihr Verhalten anhand der bereitgestellten Beispiele an, während herkömmliche Programmieralgorithmen auf statischen expliziten Anweisungen basieren, die sich nicht von selbst ändern. In diesem Sinne ist KI eine Revolution, denn das statische Schreiben der Regeln von ChatGPT 3.5 mit seinen 175 Milliarden Parametern hätte Tausende von Jahren gedauert.

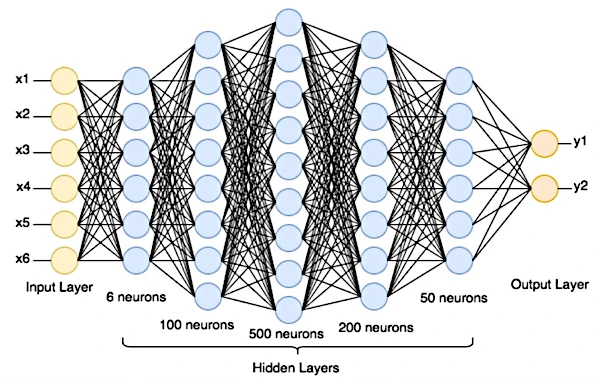

Ein neuronales Netzwerk ist in Schichten organisiert, in denen jedes künstliche Neuron (mathematische Funktion) Eingaben empfängt, Berechnungen an diesen Eingaben durchführt und eine Ausgabe generiert. Die erste Schicht ist die Eingabeschicht, die die Rohdaten (Text, digitales Bild oder andere gesammelte Daten) empfängt. Dahinter befinden sich eine oder mehrere verborgene Schichten (von außen nicht zugänglich), gefolgt von der Ausgabeschicht, die die Vorhersagen erstellt.

Um eine Vorhersage zu treffen, werden Daten von der Eingabeschicht an die Ausgabeschicht weitergegeben. Jedes Neuron summiert seine gewichteten Eingaben, wendet eine Aktivierungsfunktion an und übergibt das Ergebnis an die nächste Schicht.

Aktivierungsfunktionen führen Nichtlinearitäten in das Netzwerk ein. Dies bedeutet, dass die Beziehung zwischen Größen kein konstantes Verhältnis, sondern eine Wahrscheinlichkeit ist. Dies verleiht neuronalen Netzen die Fähigkeit, eine Vielzahl von Problemen zu lösen, von der Bilderkennung über maschinelle Übersetzung bis hin zur Modellierung natürlicher Sprache.

Nachdem eine Vorhersage getroffen wurde, vergleicht das Netzwerk seine eigenen Ergebnisse mit den richtigen Bezeichnungen, um den Fehler oder die Differenz zwischen den beiden zu messen. Korrekte Beschriftungen sind ein wesentlicher Bestandteil des Trainingssatzes eines überwachten Lernmodells. Sie werden für jedes Beispiel im Trainingssatz bereitgestellt, damit das Modell lernen kann, genaue Vorhersagen zu treffen.

Im nächsten Schritt passt der Backpropagation-Algorithmus die Netzwerkgewichte an (interne Parameter, die bestimmen, wie Neuronen auf Eingaben reagieren). Dies ermöglicht es, die Werte zu finden, die den Fehler des Modells minimieren. Dieser Vorgang wiederholt sich, bis das Netzwerk ein zufriedenstellendes Leistungsniveau erreicht.

Im Netzwerk müssen auch Hyperparameter angepasst werden, wie z. B. die Lernrate (Anzahl der Iterationen, die das Modell beim Aktualisieren der Gewichte während des Trainings durchführt), die verwendete Stapelgröße (wie viele Beispieldaten bei jeder Aktualisierung der Gewichte verwendet werden), die Netzwerkarchitektur (Anzahl der Schichten und Anzahl der Neuronen pro Schicht), die Wahl der Aktivierungsfunktion in den Schichten usw.

Nach der Bewertung des Modells für jede Kombination wählen die Forscher die Hyperparameter aus, die bei den Validierungsdaten die beste Leistung erbringen.

Letztendlich wird das trainierte Modell anhand neuer, noch nie zuvor gesehener Daten bewertet.

Nehmen wir an, wir verfügen über ein Rechenzentrum, das uns 100.000 verschiedene Bilder mit 28 x 28 Pixeln in Graustufen liefern kann, die handgeschriebene Zahlen von 0 bis 9 darstellen.

Unser neuronales Netzwerk verfügt über eine Eingabeschicht, die an die Größe der Bilder angepasst ist (28 x 28 Neuronen), eine oder mehrere verborgene Schichten und eine Ausgabeschicht mit 10 Neuronen (da es 10 mögliche Zahlen gibt: 0 bis 9). Jedes Neuron in der Ausgabeschicht stellt die Wahrscheinlichkeit dar, dass das Bild mit einer bestimmten Ziffer übereinstimmt.

Die Gewichte der Verbindungen zwischen Neuronen werden zunächst auf zufällige Werte gesetzt.

Die Rohdaten, beispielsweise das digitale Bild von 3, werden in die Eingabeschicht eingebracht.

Um lokale Bereiche des Bildes zu analysieren, gleiten Faltungsfilter (z. B. 5 x 5 Pixel) Pixel für Pixel über das Bild, um eine hierarchische visuelle Merkmalskarte zu extrahieren. Normalerweise verwendet eine Faltungsschicht mehrere verschiedene Filter. Jeder Filter lernt, bestimmte Merkmale des Bildes zu erkennen, z. B. Kanten, Texturen, Muster usw. Die von den ersten Faltungsschichten extrahierten Merkmale sind einfach (wie Kanten), während die höheren Schichten lernen, komplexere Merkmale (wie Muster oder Objekte) zu erkennen.

Daten verbreiten sich durch das Netzwerk, indem sie gewichteten Verbindungen folgen und Aktivierungsfunktionen anwenden. Auf jeder Ebene werden mathematische Operationen durchgeführt, um eine Ausgabe zu erhalten.

Die Ausgabeschicht erzeugt Bewertungen für jede Ziffer (0-9). Eine Funktion wandelt diese Ergebnisse in eine Reihe von Wahrscheinlichkeiten für jede mögliche Klasse (0-9) um. Die Zahl mit der höchsten Wahrscheinlichkeit ist die Vorhersage des Netzwerks.

Anschließend vergleicht das Netzwerk seine Vorhersage mit der tatsächlichen Beschriftung des Bildes (z. B. „Es ist eine 3“).

Eine Kostenfunktion misst die Divergenz zwischen den Modellvorhersagen und den tatsächlichen Etiketten. Es weist höhere Kosten zu, wenn die Modellvorhersagen weit von den erwarteten Bezeichnungen entfernt sind. Beim Training eines neuronalen Netzwerks besteht das Ziel darin, die Kostenfunktion zu minimieren.

Dazu wird der Fehler in die entgegengesetzte Richtung durch das Netzwerk propagiert. Diese Rückausbreitung erfolgt von den Ausgabeschichten zu den Eingabeschichten. Während sich der Fehler in umgekehrter Richtung ausbreitet, passt das Netzwerk seine Parameter (Gewichte und Bias) in jeder Schicht an, um den Fehler zu minimieren. Dies erfolgt mithilfe von Optimierungsalgorithmen wie dem Gradientenabstieg, die die Modellparameter aktualisieren. Gewichte und Vorspannungen werden entsprechend dem Farbverlauf angepasst. Die Parameter werden in die Richtung geändert, die die Kostenfunktion minimiert.

Dieser Vorgang wird an einer sehr großen Anzahl von Trainingsbildern wiederholt. Das Netzwerk passt seine Parameter bei jeder Iteration an, um die Klassifizierung handschriftlicher Ziffern zu verbessern.

Sobald das Netzwerk trainiert ist, wird es an einem separaten Datensatz (noch nicht sichtbare Bilder) getestet, um seine Leistung im Hinblick auf die Klassifizierungsgenauigkeit zu bewerten.

Das Konzept der Gewichtsveränderung wird in künstlichen neuronalen Netzen verwendet, da es von der Funktionsweise des menschlichen Gehirns inspiriert ist. Im menschlichen Gehirn sind Neuronen durch Synapsen miteinander verbunden. Die Stärke der Verbindung zwischen zwei Neuronen wird als „synaptisches Gewicht“ bezeichnet. Synaptische Gewichte werden während des menschlichen Lernprozesses verändert. Dieser noch wenig verstandene Prozess wird synaptische Plastizität genannt. Synaptische Plastizität ist ein faszinierender Prozess, der es uns ermöglicht, uns ein Leben lang anzupassen und zu lernen.

Zum Beispiel :

• Wenn wir das Wort „chien“ auf Französisch lernen, werden die Neuronen, die den „ch“-Laut, den „i“-Laut, den „e“-Laut und das Wort „chien“ repräsentieren, gemeinsam aktiviert. Je häufiger wir das Wort „Hund“ verwenden, desto mehr werden diese Neuronen gemeinsam aktiviert.

• Je mehr traumatisierte Menschen sich positiven und sicheren Erfahrungen aussetzen, desto stärker werden die Synapsen zwischen den Neuronen, die das traumatische Ereignis repräsentieren, wahrscheinlich schwächer.