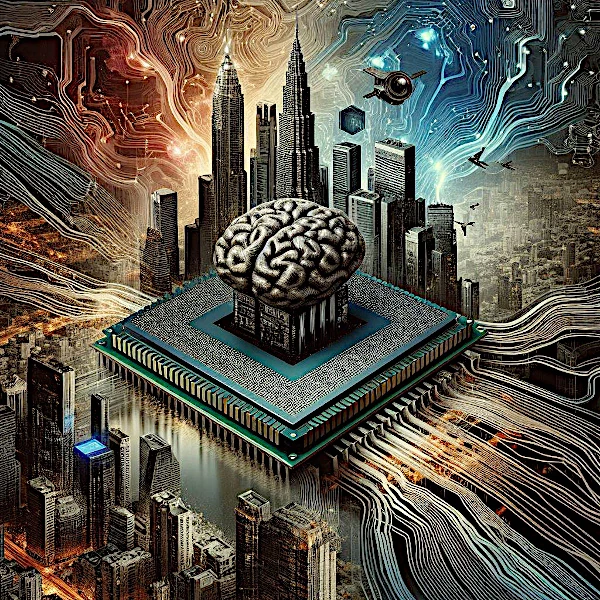

Die Verarbeitung natürlicher Sprache (NLP), unterstützt durch den Baustein „Transformer“, ist der Ursprung des großen Erfolgs der künstlichen Intelligenz. Allerdings haben auch andere Faktoren die Entstehung von KI ermöglicht, insbesondere die zunehmende Verfügbarkeit von Daten, die Speicherkapazität von Rechenzentren und der exponentielle Anstieg der Rechenleistung. Tatsächlich geht mit der Entwicklung und zunehmenden Nutzung von KI ein wachsender Bedarf an Daten, Speicherkapazität und Rechenleistung einher.

Beflügelt vom Erfolg geht dieser große Qualitätssprung mit einem kolossalen Energieschub einher.

• Die erste Quelle dieses Gigantismus liegt in der Explosion der verfügbaren Daten.

Der Aufstieg der Internet-Technologien erzeugt ein Datenvolumen, das exponentiell wächst.

Die gigantische Größe und das Wachstum der Internetdaten sind schwindelerregend.

Die Zahl ist so groß, dass Schätzungen unmöglich oder sehr ungenau sind.

Einigen Berichten zufolge (Google Cloud Platform, AWS, Microsoft Azure, IDC, Gartner, Forrester Research und andere) lag die im Internet gespeicherte Datenmenge im Jahr 2020 irgendwo zwischen 40 und 50 Zettabyte (1 Byte ist gleichbedeutend mit 1 Zeichen oder 1 Byte). Im Jahr 2021 waren es etwa 60 bis 70 Zettabyte. Im Jahr 2025 dürften es rund 180 Zettabyte sein. Diese Menge entspricht 180 Milliarden SSDs mit 1 Terabyte (TB). Das Terabyte ist mittlerweile die Speichergröße der Datenträger, die wir täglich nutzen.

* 1 Zettabyte (ZB) = 10^21 Byte, was 1.000 Exabyte oder 1.000.000 Petabyte (PB) oder 1.000.000.000 Terabyte (TB) entspricht.

Im Jahr 2024 variiert die Schätzung der täglich generierten Internetdatenmenge je nach Quelle, liegt aber im Allgemeinen bei etwa 3,5 Exabyte. Um diese tägliche Datenmenge (3,5 x 10^18 Bytes) ins rechte Licht zu rücken, können wir sie mit 625.000.000 zweistündigen HD-Filmen (≈ 4 GB Daten) vergleichen.

Laut einer Studie von Digital Universe verdoppelt sich die Datenmenge etwa alle zwei Jahre.

| Power | Symbol | Power | Symbol |

| 10^0 | 1 | 10^1 | da (deca) |

| 10^2 | h (hecto) | 10^3 | k (kilo) |

| 10^6 | M (mega) | 10^9 | G (giga) |

| 10^12 | T (tera) | 10^15 | P (peta) |

| 10^18 | E (exa) | 10^21 | Z (zetta) |

| 10^24 | Y (yotta) | 10^27 | R (ronna) |

| 10^30 | Q (quetta) |

• Die zweite Quelle dieses Gigantismus liegt in Hyperscale-Rechenzentren (den größten Rechenzentren der Welt).

Die größte Speicherkapazität konzentriert sich hauptsächlich auf große Player wie Amazon Web Services, Microsoft Azure, Google Cloud, Meta Platforms, Equinix und Digital Realty.

Dem Bericht von Omdia zufolge gibt es im Jahr 2024 weltweit etwa 8,6 Millionen Rechenzentren.

Davon sind rund 600.000 Hyperscale-Rechenzentren im Besitz von Cloud-Giganten wie Amazon, Microsoft und Google. Auch wenn es schwer abzuschätzen ist, ist es wahrscheinlich, dass sich die weltweite Datenspeicherkapazität alle zwei Jahre verdoppelt.

Der Betrieb von Rechenzentren verbraucht viel Energie und die wachsende Speicherkapazität könnte die Stromnetze belasten. Bis 2025 wird der Stromverbrauch von Rechenzentren voraussichtlich 2 % des weltweiten Stromverbrauchs erreichen.

• Die dritte Quelle dieses Gigantismus liegt in der Rechenleistung von Maschinen, gemessen in FLOPs (Floating-Point Operations Per Second).

Im Jahr 2024 können Prozessoren (CPUs) eine Rechenleistung von 1228 GFLOPs erreichen, also etwa 1 Teraflops wie der ProzessorIntel Core i9-13900K.

Grafik-Coprozessoren sind für die Ausführung spezifischer Aufgaben oder mathematischer Berechnungen noch leistungsfähiger. Diese Hardwarebeschleuniger (GPU, FPGA) können eine Rechenleistung von 100 Teraflops erreichen, wie die NVIDIA GeForce RTX 4090 Ti-Karte, die mit 18.176 Kernen arbeitet.

Aus diesem Grund nutzen die schnellsten Supercomputer der Welt sowohl die Rechenleistung von CPUs als auch die von GPUs. So haben Supercomputer eine Leistung im Petabereich erreicht (mehrere Millionen Milliarden Operationen pro Sekunde).

Im Jahr 2024 wird dieHPE Frontier in den Vereinigten Staaten, erreichte Exascale-Leistung.

* 1 Exaflops entspricht einer Milliarde Milliarden Operationen pro Sekunde.

Exponentielles Wachstum kann nicht lange anhalten!