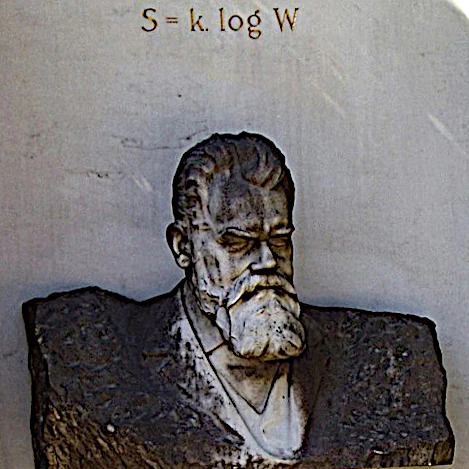

L'Equation de l'Entropie a été développée par le physicien autrichien Ludwig Boltzmann. L'entropie (S) est un concept puissant qui mesure le désordre ou l'incertitude d'un système physique.

L'équation de l'entropie de Boltzmann est essentielle pour comprendre la relation entre l'entropie et les propriétés thermodynamiques d'un système, comme la température, la pression et l'énergie. Elle joue un rôle crucial dans l'étude des processus d'équilibrage thermodynamique, de l'évolution des systèmes physiques, et dans l'interprétation statistique des lois de la thermodynamique.

L'équation de l'entropie de Boltzmann s'exprime généralement comme suit : S = klog(W)

Cette équation montre que l'entropie est proportionnelle au logarithme du nombre de micro-états possibles du système.

Un système est dit avoir une entropie élevée s'il peut se trouver dans un grand nombre de micro-états désordonnés (plus de désordre), tandis qu'un système ayant peu de micro-états accessibles aura une entropie plus faible (plus d'ordre).

Le logarithme transforme des grandes valeurs en des valeurs plus petites, ce qui permet de mieux gérer certains calculs en physique et en mathématiques. Si l'on utilisait directement ���� dans l'équation de Boltzmann, on obtiendrait des valeurs d'entropie énormes et difficiles à interpréter. Le logarithme sert donc à rendre ces valeurs plus manipulables et à respecter des propriétés mathématiques essentielles, comme l’additivité de l'entropie. En somme, même si un logarithme est "beaucoup plus petit", il nous donne une échelle plus pratique pour raisonner sur des systèmes où les nombres de micro-états sont gigantesques. C'est un peu comme mesurer des distances astronomiques en années-lumière au lieu de kilomètres !

L'équation de Boltzmann n'est pas directement à l'origine de la découverte de l'atome, mais elle a joué un rôle crucial dans la compréhension théorique de la nature atomique de la matière et dans le développement de la physique statistique, qui a confirmé l'existence des atomes.

S = klog(W) relie le comportement microscopique (mouvement des atomes) aux propriétés macroscopiques (pression, température, entropie).

L'entropie est un concept fondamental utilisé dans divers domaines de la science, notamment en thermodynamique, en mécanique statistique, en théorie de l'information, en informatique, en sciences de la complexité et dans d'autres domaines.

La définition de l'entropie peut varier légèrement selon le contexte, mais elle partage des idées communes dans ces domaines.

Dans tous les cas, l'entropie est une mesure de la quantité d'information, de désordre, de diversité ou d'incertitude dans un système.

Pourtant, dans l'univers, nous observons des structures de plus en plus ordonnées qui se forment à partir de processus initialement moins organisés. Cela semble aller à l'encontre de l'idée intuitive que l'entropie, en tant que mesure du désordre, doit toujours augmenter, comme le suggère le deuxième principe de la thermodynamique.

L'augmentation de l'ordre local (comme la formation de galaxies et d'étoiles) n'implique pas une violation du deuxième principe de la thermodynamique. Ce principe concerne l'ensemble du système, et il stipule que l'entropie totale d'un système isolé, l'Univers, ne peut pas diminuer au fil du temps.

Lorsque nous observons la formation de galaxies et d'étoiles, nous devons tenir compte de l'ensemble du système, y compris l'énergie et les processus impliqués à grande échelle. Ainsi, ce qui peut sembler être une diminution du désordre à petite échelle est en réalité une simple redistribution de l'énergie et de l'entropie à une échelle plus vaste.

Les structures qui émergent dans l’Univers ne sont donc pas une anomalie, mais une manifestation de processus physiques fondamentaux, où l'organisation locale s'accompagne toujours d'une dissipation de l'énergie ailleurs.

La dissipation de l'énergie se produit principalement sous forme de rayonnement thermique. Lorsqu'une structure ordonnée se forme localement, comme une étoile ou une galaxie, le système global augmente son entropie, par exemple :

En bref, l’Univers équilibre la création de structures ordonnées en redistribuant de l’énergie sous forme de rayonnement et d’autres processus dissipatifs, garantissant que le deuxième principe de la thermodynamique est toujours respecté. Loin d’être une illusion, cet ordre apparent est une facette naturelle du chaos cosmique.