Foto : IAs generativas (GPT-3, Copilot, Gemini, Gopher, Chinchilla, PaLM, Human, etc.) treinam em grandes conjuntos de dados (textos, imagens, áudio ou vídeos) produzidos por humanos.

No entanto, essas IAs ficam “loucas” quando elas mesmas geram seus próprios dados de treinamento.

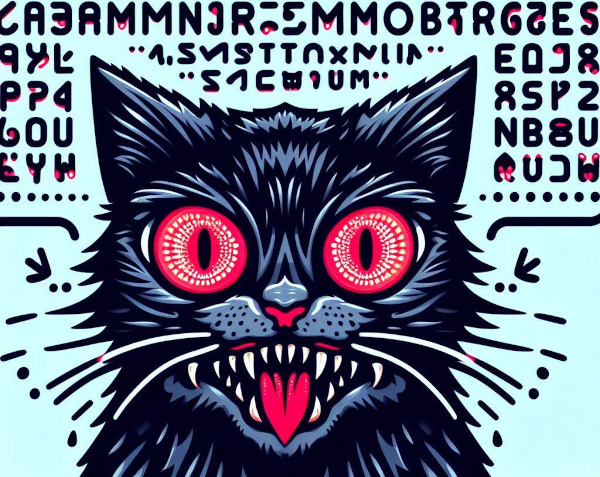

Imagem: imagem gerada por uma IA.

O conceito de “Modelos Gerativos Autoconsumidores Enlouquecem” refere-se, no campo da inteligência artificial, à produção de dados de aprendizagem pela própria IA.

Modelos generativos são algoritmos que aprendem a gerar novos dados, “imitando” um conjunto de dados de treinamento produzidos por humanos. A produção de dados de treinamento é cara e demorada. Os dados devem ser coletados, limpos, anotados e formatados para que possam ser utilizados corretamente pela IA.

Os cientistas não resistiram à tentação de utilizar os dados sintéticos gerados pelos próprios modelos generativos para treinar novos modelos mais rapidamente.

A ideia central é criar um modelo generativo capaz de produzir seus próprios dados de treinamento. Este processo é então iterado, com o modelo sendo refinado e tornando-se cada vez mais capaz de gerar dados complexos, cada vez mais numerosos e novos.

Os benefícios imaginados são numerosos. Em primeiro lugar, o modelo não é limitado pela quantidade de dados de treino inicial. Ele pode assim explorar áreas desconhecidas e descobrir novos conceitos por acaso. Além disso, o modelo, graças à sua própria aprendizagem auto-supervisionada, poderia refinar-se e melhorar o seu desempenho iterativamente. Por exemplo, o modelo poderia gerar novas estruturas moleculares que seriam candidatas a novos medicamentos.

No entanto, existe um enorme desafio associado a esta abordagem.

Modelos generativos autoconsumidores enlouquecem é um fenômeno que ocorre quando modelos generativos de inteligência artificial treinam em dados sintéticos produzidos por outros modelos generativos de IA, criando assim loops autofágicos (que se consomem). Quando uma IA tenta aprender o conteúdo gerado por uma IA, ela enlouquece.

A repetição desse processo mal compreendido cria um ciclo autofágico cujos dados de aprendizagem se tornam caóticos. Além disso, é tentador usar dados sintéticos para aumentar ou substituir dados reais devido à falta de dados disponíveis. Em outras palavras, quando o modelo não possui dados reais novos suficientes cada vez que um loop autofágico é gerado, os modelos generativos futuros estão fadados ao fracasso.

Este processo de autofagia leva a uma diminuição progressiva da qualidade e a uma diluição da diversidade do conteúdo gerado. Isto é caracterizado por uma degeneração do processo, onde o modelo começa a produzir resultados cada vez mais inconsistentes e redundantes.

Se o modelo não for exposto a uma variedade suficiente de exemplos, terá dificuldade em aprender padrões significativos e, assim, recorrerá a produções repetitivas.

Da mesma forma, se o modelo for encorajado a concentrar-se apenas na optimização dos seus próprios resultados, pode afastar-se da realidade e gerar resultados cada vez mais aberrantes.

Finalmente, o modelo tenderá a ajustar demasiado as suas respostas aos dados de treino (overfitting). Ele começa a memorizar detalhes insignificantes e perde a capacidade de generalizar para novos exemplos. Além disso, pode reproduzir indefinidamente os seus próprios preconceitos e deficiências.

Em alguns cenários teóricos, os modelos generativos podem enlouquecer ou funcionar mal de uma forma imprevista e potencialmente autodestrutiva. Por exemplo, um modelo generativo poderia favorecer a “novidade” e esta busca incessante poderia empurrá-lo para explorar territórios cada vez mais desconhecidos.

A ausência de regulamentação expõe o modelo a uma fuga cujo conteúdo pode ser cada vez mais extremo, ofensivo, perturbador ou chocante, flertando com o inaceitável. Poderemos não mais compreender ou interpretar os resultados gerados pelo modelo.

Esta noção especulativa destaca potenciais preocupações associadas à utilização de modelos de inteligência artificial autónomos ou insuficientemente controlados. Embora possa parecer uma ideia de ficção científica, é um pensamento importante na comunidade de IA sobre como projetar e regular essas tecnologias de forma responsável.

Em resumo, quando os modelos de IA treinam com os seus próprios dados, isolam-se cada vez mais do mundo real e dos seus valores, enlouquecem!