Imagen : Las IA generativas (GPT-3, Copilot, Gemini, Gopher, Chinchilla, PaLM, Human, etc.) se entrenan con grandes conjuntos de datos (textos, imágenes, audio o vídeos) producidos por humanos.

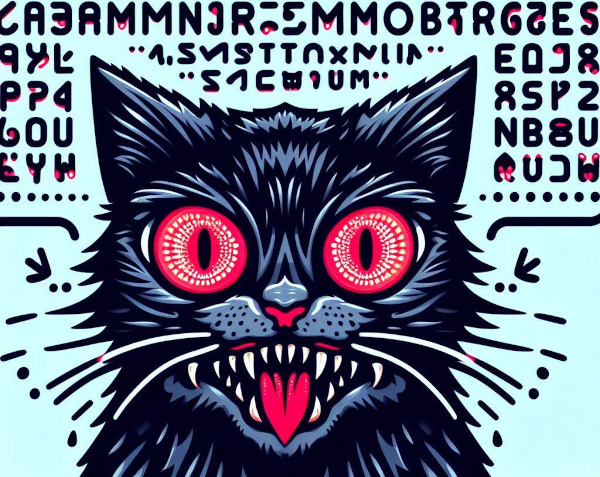

Sin embargo, estas IA se vuelven “locas” cuando ellas mismas generan sus propios datos de entrenamiento.

Imagen: imagen generada por una AI.

El concepto de “Los modelos generativos de autoconsumo se vuelven locos” se refiere, en el campo de la inteligencia artificial, a la producción de datos de aprendizaje por parte de la propia IA.

Los modelos generativos son algoritmos que aprenden a generar nuevos datos “imitando” un conjunto de datos de entrenamiento producidos por humanos. Producir datos de entrenamiento es costoso y requiere mucho tiempo. Los datos deben recopilarse, limpiarse, anotarse y formatearse para que la IA pueda utilizarlos correctamente.

Los científicos no han resistido la tentación de utilizar los datos sintéticos generados por los propios modelos generativos para entrenar nuevos modelos más rápidamente.

La idea central es crear un modelo generativo capaz de producir sus propios datos de entrenamiento. Luego, este proceso se repite, y el modelo se refina y se vuelve cada vez más capaz de generar datos complejos, cada vez más numerosos y nuevos.

Los beneficios imaginados son numerosos. En primer lugar, el modelo no está limitado por la cantidad de datos de entrenamiento inicial. De esta manera puede explorar áreas desconocidas y descubrir nuevos conceptos por casualidad. Además, el modelo, gracias a su propio aprendizaje autosupervisado, podría refinarse y mejorar su rendimiento de forma iterativa. Por ejemplo, el modelo podría generar nuevas estructuras moleculares que sean candidatas para nuevos fármacos.

Sin embargo, existe un enorme desafío asociado con este enfoque.

Los modelos generativos autoconsumidos se vuelven locos es un fenómeno que ocurre cuando los modelos generativos de inteligencia artificial se entrenan con datos sintéticos producidos por otros modelos generativos de IA, creando así bucles autofágicos (que se consumen a sí mismos). Cuando una IA intenta aprender contenido generado por otra IA, se vuelve loca.

La repetición de este proceso poco comprendido crea un bucle autofágico cuyos datos de aprendizaje se vuelven caóticos. Además, resulta tentador utilizar datos sintéticos para aumentar o reemplazar datos reales debido a la falta de datos disponibles. En otras palabras, cuando el modelo no tiene suficientes datos reales nuevos cada vez que se genera un bucle autofágico, los futuros modelos generativos están condenados al fracaso.

Este proceso de autofagia conduce a una disminución progresiva de la calidad y una dilución de la diversidad del contenido generado. Esto se caracteriza por una degeneración del proceso, donde el modelo comienza a producir resultados cada vez más inconsistentes y redundantes.

Si el modelo no está expuesto a una variedad suficiente de ejemplos, tiene dificultades para aprender patrones significativos y, por tanto, recurre a producciones repetitivas.

Del mismo modo, si se anima al modelo a centrarse únicamente en optimizar su propio resultado, puede desviarse de la realidad y generar resultados cada vez más aberrantes.

Finalmente, el modelo tenderá a ajustar demasiado sus respuestas a los datos de entrenamiento (sobreajuste). Comienza a memorizar detalles insignificantes y pierde la capacidad de generalizar a nuevos ejemplos. Además, puede reproducir infinitamente sus propios prejuicios y deficiencias.

En algunos escenarios teóricos, los modelos generativos podrían volverse "locos" o funcionar mal de una manera imprevista y potencialmente autodestructiva. Por ejemplo, un modelo generativo podría favorecer la “novedad” y esta búsqueda incesante podría empujarlo a explorar territorios cada vez más desconocidos.

La ausencia de regulación expone el modelo a un desbocado cuyo contenido podría ser cada vez más extremo, ofensivo, inquietante o chocante, coqueteando con lo inaceptable. Es posible que ya no entendamos ni interpretemos los resultados generados por el modelo.

Esta noción especulativa resalta las posibles preocupaciones asociadas con el uso de modelos de inteligencia artificial autónomos o insuficientemente controlados. Si bien esto puede parecer una idea de ciencia ficción, es un pensamiento importante en la comunidad de IA sobre cómo diseñar y regular estas tecnologías de manera responsable.

En resumen, cuando los modelos de IA se entrenan con sus propios datos, se aíslan cada vez más del mundo real y sus valores, ¡se vuelven locos!