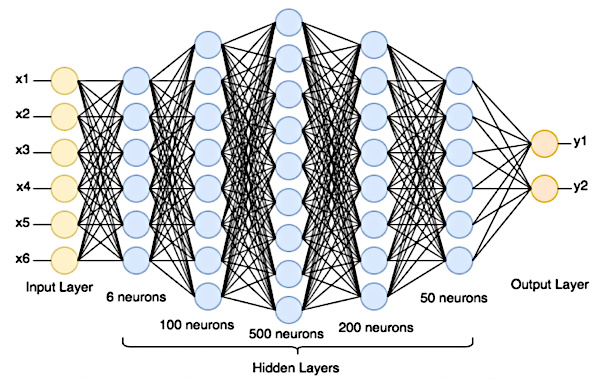

Imagen: Una red neuronal artificial está formada por una sucesión de capas de neuronas interconectadas, cada una de las cuales toma sus entradas de las salidas de la capa anterior. En una red neuronal artificial, el número de neuronas por capa puede ser de decenas de miles y el número de capas puede llegar a varios cientos. Crédito de la imagen: dominio público.

Para comprender cómo funcionan las redes neuronales artificiales, es necesario comprender el significado de inteligencia artificial (IA). La IA consiste en crear sistemas informáticos capaces de automatizar tareas sin intervención humana, pero también de aprender, adaptarse, mejorar, comunicar y sobre todo tomar decisiones. En este sentido, la IA busca reproducir aspectos de la inteligencia humana.

La definición de inteligencia es muy discutible, pero el significado que aquí nos interesará es el de funciones controladas por el cerebro. De hecho, ya sean mecánicas como caminar o cognitivas como la toma de decisiones, la arquitectura de las funciones sigue siendo la misma en todas las áreas cerebrales de nuestro cerebro. Además, todas las funciones tienen la misma importancia, sin distinción entre las consideradas nobles o menos nobles. Todos se llevan a cabo con la misma complejidad de cálculos, a través de una enorme red de miles de millones de neuronas interconectadas entre ellas para intercambiar información. La información se intercambia a través de señales eléctricas y químicas.

En el cerebro humano, el proceso de comunicación entre neuronas es el siguiente:

- Cuando las señales eléctricas, iniciadas en la membrana celular de la neurona, alcanzan un umbral crítico, desencadenan un breve impulso eléctrico llamado "potencial de acción". Los potenciales de acción viajan a lo largo del axón hasta la sinapsis de la neurona.

- A nivel de las sinapsis (puntos de contacto entre neuronas) los potenciales de acción desencadenan la liberación de moléculas químicas, llamadas "neurotransmisores".

- Luego, los neurotransmisores se unen a receptores ubicados en la membrana de la neurona postsináptica (la neurona receptora). Este enlace químico desencadena una respuesta eléctrica en la neurona postsináptica.

- La neurona postsináptica integra todas las entradas que recibe de las neuronas transmisoras y, si se alcanza el umbral crítico, genera a su vez un potencial de acción que se propaga a lo largo de su propio axón, continuando así la transmisión de la información en la red.

Dependiendo de los tipos de neurotransmisores liberados, la actividad presináptica puede tener un efecto excitador o inhibidor sobre la actividad eléctrica de la neurona postsináptica. Esto hace que la activación de un potencial de acción sea más o menos probable.

Este complejo proceso es la base de la función cerebral y la cognición humana. A partir de este proceso, los investigadores desarrollarán un modelo de inteligencia artificial, muy simple al principio y luego cada vez más sofisticado a medida que avanza el progreso tecnológico.

La neurona artificial es la unidad básica de una red neuronal artificial. Una red neuronal artificial está formada por una sucesión de capas de neuronas interconectadas, cada una de las cuales toma sus entradas de las salidas de la capa anterior.

Las neuronas artificiales no son bits de computadora (0 o 1), sino abstracciones matemáticas (números, operaciones, funciones, ecuaciones, matrices, conjuntos, probabilidades, etc.). En otras palabras, son unidades de procesamiento que realizan operaciones matemáticas sobre los datos que se les presentan. No almacenan datos, mientras que los bits de computadora son la base para almacenar información digital.

En una red neuronal artificial, cada neurona se caracteriza por un nivel de actividad capturado por una variable llamada "potencial de activación". La sinapsis de la neurona se caracteriza por otra variable llamada “peso sináptico”.

- El potencial de activación representa el estado eléctrico de la neurona postsináptica en un momento dado. Se calcula sumando las señales de entrada de las neuronas presinápticas, con cada señal modulada por el peso sináptico correspondiente. El potencial de activación puede variar continuamente en un rango de valores negativos a positivos, dependiendo de la intensidad de las señales entrantes.

- Los pesos sinápticos determinan si una conexión sináptica es excitadora, inhibidora o nula. Los pesos modulan el impacto de las señales de entrada sobre el potencial de activación. Los pesos positivos aumentan la actividad, los negativos la reducen y los pesos cero no tienen ningún efecto.

El potencial de activación resulta de la combinación de señales de entrada ponderadas por los pesos sinápticos. Luego, este potencial se somete a una función de activación, que introduce una no linealidad y determina si la neurona postsináptica genera una respuesta (potencial de acción) o no. En última instancia, estos mecanismos permiten que la neurona procese información y responda a los estímulos de forma adaptativa. El funcionamiento de estas variables es fundamental para modelar el comportamiento de las neuronas, tanto en redes neuronales biológicas como en redes neuronales artificiales.

Imaginemos una red neuronal artificial utilizada para la clasificación de imágenes. Esta red incluye una neurona postsináptica que recibe conexiones de tres neuronas presinápticas. Cada una de estas tres neuronas presinápticas está asociada a una característica específica de la imagen que la red analiza, por ejemplo, la presencia de líneas verticales, líneas horizontales y curvas.

La neurona postsináptica tiene un potencial de activación inicial de 0.

Cuando las tres neuronas presinápticas envían sus señales, cada señal se multiplica por el peso sináptico asociado a la conexión correspondiente. Supongamos que los pesos sinápticos son:

- Peso sináptico para la característica de líneas verticales: +0,5

- Peso sináptico para la característica de líneas horizontales: -0,3

- Peso sináptico para la característica de las curvas: +0,2

Las señales de las tres neuronas presinápticas se ponderan según los pesos sinápticos respectivos y se suman.

Si tenemos las siguientes señales:

- Señal para líneas verticales: 1

- Señal para líneas horizontales: 0,5

- Señal para curvas: 0,8

El potencial de activación se calcularía de la siguiente manera:

Potencial de activación = (1 * 0,5) + (0,5 * (-0,3)) + (0,8 * 0,2) = 0,5 - 0,15 + 0,16 = 0,51

Si el potencial de activación excede un umbral definido (por ejemplo, 0), la neurona postsináptica generará un potencial de acción, lo que indica que se ha detectado la característica deseada en la imagen.

En este ejemplo, los pesos sinápticos desempeñan un papel crucial a la hora de determinar la importancia relativa de cada característica de la imagen. Las señales de entrada ponderadas por los pesos sinápticos se utilizan para calcular el potencial de activación que, si supera el umbral, desencadenará la respuesta de la neurona postsináptica. Esto permite que la red neuronal tome decisiones basadas en las características detectadas en la imagen.

La infraestructura hardware de una red neuronal artificial no es biológica, es la misma que la de la informática clásica (microprocesadores, tarjetas gráficas, etc.).

La infraestructura de software de una red neuronal artificial es diferente. Los algoritmos de aprendizaje automático aprenden de los datos y ajustan su comportamiento en función de los ejemplos proporcionados, mientras que los algoritmos de programación tradicionales se basan en instrucciones explícitas estáticas que no cambian por sí solas. En este sentido, la IA es una revolución, porque para escribir estáticamente las reglas de ChatGPT 3.5 con sus 175 mil millones de parámetros, se habrían necesitado miles de años.

Una red neuronal está organizada en capas donde cada neurona artificial (función matemática) recibe entradas, realiza cálculos sobre estas entradas y genera una salida. La primera capa es la capa de entrada, que recibe los datos sin procesar (texto, imagen digital u otros datos recopilados). Detrás de él, hay una o más capas ocultas (no accesibles desde el exterior), seguidas de la capa de salida que produce las predicciones.

Para hacer una predicción, los datos se propagan desde la capa de entrada a la capa de salida. Cada neurona suma sus entradas ponderadas, aplica una función de activación y pasa el resultado a la siguiente capa.

Las funciones de activación introducen no linealidades en la red. Esto significa que la relación entre cantidades no es una proporción constante sino una probabilidad. Esto es lo que da a las redes neuronales su capacidad para resolver una variedad de problemas, desde el reconocimiento de imágenes hasta la traducción automática y el modelado de lenguaje natural.

Después de hacer una predicción, la red compara sus propios resultados con las etiquetas correctas para medir el error o la diferencia entre las dos. Las etiquetas correctas son un componente esencial del conjunto de entrenamiento de un modelo de aprendizaje supervisado. Se proporcionan para cada ejemplo del conjunto de entrenamiento para permitir que el modelo aprenda a hacer predicciones precisas.

En el siguiente paso, el algoritmo de retropropagación ajusta los pesos de la red (parámetros internos que determinan cómo reaccionan las neuronas a las entradas). Esto le permite encontrar los valores que minimicen el error del modelo. Este proceso se repite hasta que la red alcanza un nivel de rendimiento satisfactorio.

En la red, también hay hiperparámetros para ajustar, como la tasa de aprendizaje (número de iteraciones que realiza el modelo al actualizar los pesos durante el entrenamiento), el tamaño del lote utilizado (cuántos ejemplos de datos se utilizan cada vez que se actualizan los pesos), el arquitectura de red (número de capas y número de neuronas por capa), elección de la función de activación en las capas, etc.

Después de evaluar el modelo para cada combinación, los investigadores eligen los hiperparámetros que brindan el mejor rendimiento en los datos de validación.

En última instancia, el modelo entrenado se evalúa a partir de datos nuevos nunca antes vistos.

Supongamos que tenemos un centro de datos capaz de proporcionarnos 100.000 imágenes diferentes de 28x28 píxeles en escala de grises que representan números escritos a mano del 0 al 9.

Nuestra red neuronal tendrá una capa de entrada configurada al tamaño de las imágenes (28x28 neuronas), una o más capas ocultas y una capa de salida con 10 neuronas (porque hay 10 números posibles: del 0 al 9). Cada neurona en la capa de salida representa la probabilidad de que la imagen coincida con un dígito en particular.

Los pesos de las conexiones entre neuronas se establecen inicialmente en valores aleatorios.

Los datos sin procesar, por ejemplo la imagen digital de 3, se introducen en la capa de entrada.

Para analizar regiones locales de la imagen, los filtros de convolución (por ejemplo, 5x5 píxeles) se deslizan sobre la imagen, píxel por píxel, para extraer un mapa de características visuales jerárquico. Normalmente, una capa de convolución utilizará varios filtros diferentes. Cada filtro aprende a detectar características específicas de la imagen, como bordes, texturas, patrones, etc. Las características extraídas por las primeras capas convolucionales son simples (como bordes), mientras que las capas superiores aprenden a reconocer características más complejas (como patrones u objetos).

Los datos se propagan a través de la red siguiendo conexiones ponderadas y aplicando funciones de activación. En cada capa, se realizan operaciones matemáticas para obtener un resultado.

La capa de salida produce puntuaciones para cada dígito (0-9). Una función transformará estas puntuaciones en una serie de probabilidades para cada clase posible (0-9). El número con mayor probabilidad será la predicción de la red.

Luego, la red comparará su predicción con la etiqueta real de la imagen (por ejemplo, "es un 3").

Una función de costo mide la divergencia entre las predicciones del modelo y las etiquetas reales. Asigna un costo mayor cuando las predicciones del modelo están lejos de las etiquetas esperadas. Al entrenar una red neuronal, el objetivo es minimizar la función de costos.

Para ello, el error se propaga en sentido contrario a través de la red. Esta retropropagación va desde las capas de salida a las capas de entrada. A medida que el error se propaga en dirección inversa, la red ajusta sus parámetros (pesos y sesgos) en cada capa para minimizar el error. Esto se hace mediante algoritmos de optimización, como el descenso de gradiente, que actualizan los parámetros del modelo. Los pesos y sesgos se ajustan según el gradiente. Los parámetros se cambian en la dirección que minimiza la función de costos.

Este proceso se repite en una gran cantidad de imágenes de entrenamiento. La red ajustará sus parámetros en cada iteración para mejorar la clasificación de dígitos escritos a mano.

Una vez entrenada la red, se prueba en un conjunto de datos separado (imágenes aún no vistas) para evaluar su desempeño en términos de precisión de clasificación.

El concepto de cambio de peso se utiliza en redes neuronales artificiales porque está inspirado en el funcionamiento del cerebro humano. En el cerebro humano, las neuronas están conectadas entre sí mediante sinapsis. La fuerza de la conexión entre dos neuronas se llama "peso sináptico". Los pesos sinápticos cambian durante el proceso de aprendizaje humano. Este proceso, aún poco comprendido, se llama plasticidad sináptica. La plasticidad sináptica es un proceso fascinante que nos permite adaptarnos y aprender a lo largo de la vida.

Por ejemplo :

• Si aprendemos la palabra "chien" en francés, las neuronas que representan el sonido "ch", el sonido "i", el sonido "e" y la palabra "chien" se activan juntas. Cuanto más usamos la palabra "perro", más se activan estas neuronas juntas.

• Cuanto más se exponen las personas traumatizadas a experiencias positivas y seguras, es más probable que se debiliten las sinapsis entre las neuronas que representan el evento traumático.