Les IA génératives, comme GPT-3, Copilot ou Gemini, s’entraînent sur des ensembles de données massifs, comprenant des milliards de textes, d’images, de musiques ou de vidéos. Ces réseaux de neurones profonds, composés de millions, voire de milliards de paramètres, posent une question fascinante : comment l'augmentation de ces paramètres peut-elle donner naissance à une forme d'intelligence ?

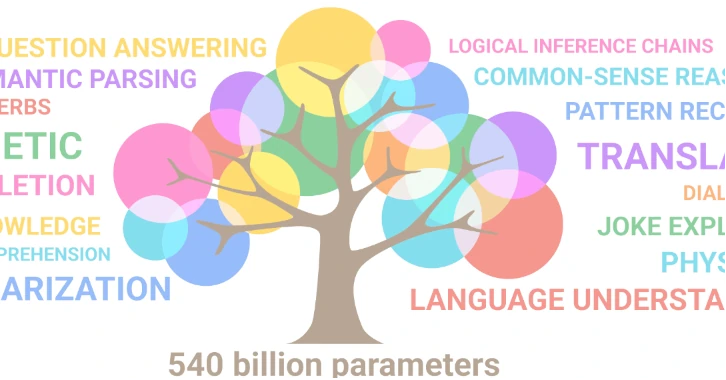

Les paramètres sont les variables internes d'un modèle d'IA, ajustés automatiquement pendant l’apprentissage. Par exemple, GPT-3 d’OpenAI contient 175 milliards de paramètres, tandis que DALL-E en a 12 milliards. Ces paramètres déterminent la capacité du modèle à apprendre et à produire des résultats cohérents. Plus le nombre de paramètres est élevé, plus le modèle peut capturer des nuances complexes dans les données.

Cependant, il existe une limite : le surapprentissage. Lorsque le nombre de paramètres dépasse la quantité de données disponibles, le modèle perd en généralisation. Pour éviter cela, il faut équilibrer la taille du modèle et la quantité de données d’apprentissage.

Les réseaux de neurones artificiels (RNA) fonctionnent en effectuant des calculs simples : chaque neurone combine ses entrées, applique une fonction d'activation et transmet le résultat à la couche suivante. Pourtant, de ce processus mathématique basique émerge une capacité à générer des phrases cohérentes et contextuellement pertinentes.

L'IA ne comprend pas le sens des mots, mais elle prédit le prochain mot ou "token" en fonction des probabilités apprises. Malgré cela, elle donne l'impression de comprendre le contexte, les intentions et les nuances du langage. Cette émergence de comportements "intelligents" à partir de règles simples est l'un des aspects les plus intrigants de l'IA.

L'émergence est un concept scientifique qui décrit l'apparition de propriétés nouvelles à partir de l'interaction de composants simples. Par exemple, après le Big Bang, la matière est apparue à partir de l'énergie pure. De même, la vie émerge de l'interaction complexe de molécules chimiques.

En 2017, avec l'avènement de GPT-2, les chercheurs ont observé une transition de phase : au-delà d'un certain seuil de données et de paramètres, les performances des modèles d'IA se sont améliorées de manière spectaculaire. Cette transition a marqué l'émergence de capacités cognitives sophistiquées, comme la génération de texte de qualité humaine.

L'IA évolue à un rythme effréné. Avec l'augmentation de la complexité des modèles, de nouvelles propriétés pourraient émerger, comme la créativité, la compréhension du réel, ou même une forme de conscience. Ces avancées pourraient révolutionner notre compréhension de l'intelligence, tant artificielle que biologique.

En parallèle, l'IA pourrait aider à percer les mystères du cerveau humain. En étudiant comment les réseaux de neurones artificiels apprennent et évoluent, les scientifiques pourraient mieux comprendre les mécanismes de la cognition humaine.

"Le hasard est le dieu des inventeurs." - Pierre Dac